はじめに

これまでウェブ上のオーディオはかなり原始的であり、非常に最近までFlashやQuickTimeなどのプラグインを利用する必要がありました。HTML5で

audio

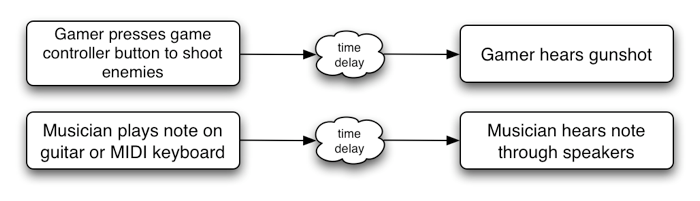

要素が導入されたことは非常に重要で、基本的なストリーミングオーディオ再生が可能になりました。しかし、より複雑なオーディオアプリケーションを扱うには十分なパワーがありません。高度なウェブベースのゲームやインタラクティブアプリケーションには、別のソリューションが必要です。本仕様の目標は、現代のゲームオーディオエンジンにある機能や、現代のデスクトップオーディオ制作アプリケーションで行われるミキシング、処理、フィルタリングのタスクの一部を含めることです。

APIは多様なユースケース[webaudio-usecases]を念頭に設計されています。理想的には、最適化されたC++エンジンをスクリプトで制御し、ブラウザで実行可能なあらゆるユースケースをサポートできるべきです。ただし、現代のデスクトップオーディオソフトウェアは非常に高度な機能を持ち、一部は本システムで構築するのが困難または不可能な場合もあります。AppleのLogic Audioはその一例で、外部MIDIコントローラ、任意のプラグインオーディオエフェクトやシンセサイザー、高度に最適化されたダイレクト・トゥ・ディスクのオーディオファイル読取/書込、緊密に統合されたタイムストレッチなどに対応しています。それでも、提案されているシステムはかなり多様な複雑なゲームやインタラクティブアプリケーション(音楽関連も含む)を十分にサポート可能です。そしてWebGLの高度なグラフィック機能と非常に良い補完関係になります。APIは後からさらに高度な機能を追加できるよう設計されています。

機能

APIがサポートする主な機能は以下の通りです:

-

モジュラー型ルーティングによるシンプルまたは複雑なミキシング/エフェクト構成。

-

内部処理に32ビット浮動小数点を使用する高ダイナミックレンジ。

-

サンプル精度のスケジュール済みサウンド再生と、低レイテンシによる、 ドラムマシンやシーケンサーなど非常に高いリズム精度が必要な音楽用途への対応。エフェクトの動的生成も含みます。

-

エンベロープやフェードイン/フェードアウト、グラニュラーエフェクト、フィルタースイープ、LFOなどのオーディオパラメータの自動化。

-

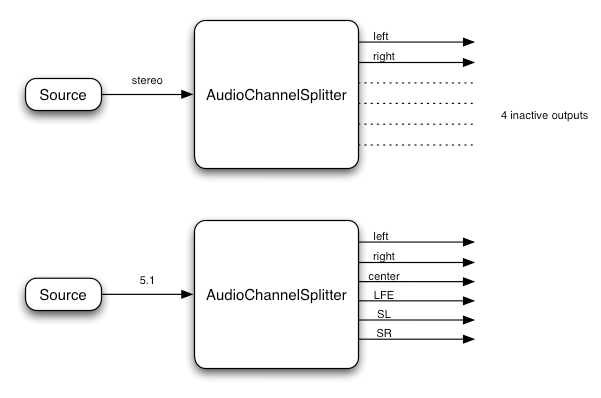

オーディオストリーム内のチャンネルを柔軟に扱い、分割・合成が可能。

-

audioやvideomedia elementからのオーディオソースの処理。 -

MediaStreamを用いたライブオーディオ入力の処理。取得にはgetUserMedia()を使用。 -

WebRTCとの統合

-

MediaStreamTrackAudioSourceNodeを使ってリモートピアから受信したオーディオの処理、[webrtc]。 -

MediaStreamAudioDestinationNodeを使って生成または処理されたオーディオストリームをリモートピアへ送信、[webrtc]。

-

-

スクリプトで直接 オーディオストリームの合成・処理。

-

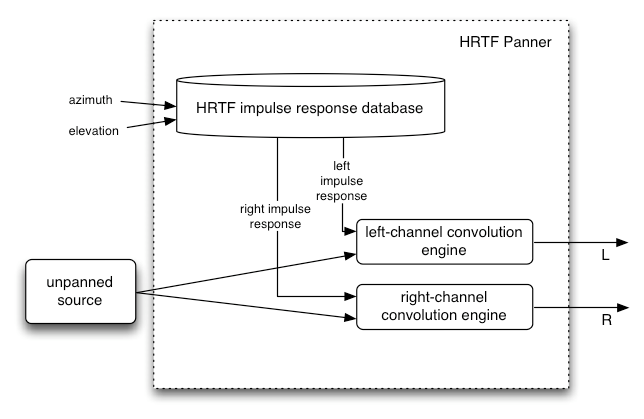

空間化オーディオによる幅広い3Dゲームや没入型環境への対応:

-

パンニングモデル:equalpower、HRTF、パススルー

-

距離減衰

-

サウンドコーン

-

遮蔽・遮断

-

ソース/リスナーに基づく

-

-

幅広い線形エフェクト(特に高品質なルームエフェクト)に対応したコンボリューションエンジン。例えば:

-

小部屋/大部屋

-

大聖堂

-

コンサートホール

-

洞窟

-

トンネル

-

廊下

-

森

-

円形劇場

-

ドア越しの遠くの部屋の音

-

極端なフィルター

-

奇妙な逆再生効果

-

極端なコムフィルター効果

-

-

ミックス全体のコントロールや音質向上のためのダイナミクスコンプレッション

-

ローパス、ハイパスなどの一般的なフィルターに対応した効率的なバイカッドフィルター。

-

歪みや非線形効果のためのウェーブシェイピングエフェクト

-

オシレーター

モジュラー型ルーティング

モジュラー型ルーティングでは、異なるAudioNode

オブジェクト間で任意の接続が可能です。各ノードは入力や出力を持つことができます。

ソースノードは入力を持たず、出力は1つだけです。

デスティネーションノードは入力が1つで出力はありません。他のノード(フィルター等)はソースとデスティネーションの間に配置できます。開発者は、2つのオブジェクトを接続するときに低レベルのストリームフォーマット詳細を心配する必要はなく、適切に処理されます。

例えば、モノラルのオーディオストリームをステレオ入力に接続すれば、適切に左右チャンネルにミックスされます。

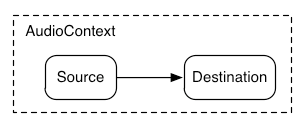

最も単純な場合、1つのソースを直接出力へルーティングできます。

すべてのルーティングは、AudioContext

内で、単一のAudioDestinationNode

によって行われます:

この単純なルーティングを図示すると、単一のサウンドを再生する簡単な例は以下の通りです:

const context= new AudioContext(); function playSound() { const source= context. createBufferSource(); source. buffer= dogBarkingBuffer; source. connect( context. destination); source. start( 0 ); }

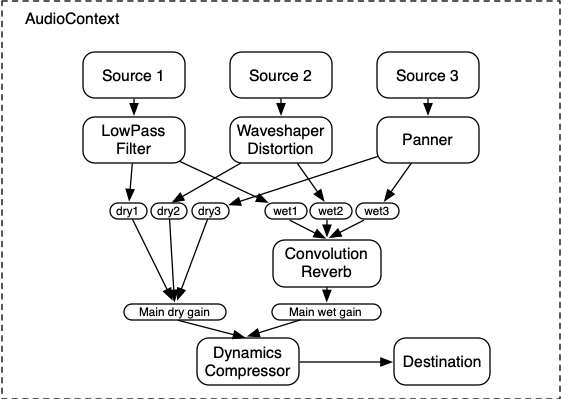

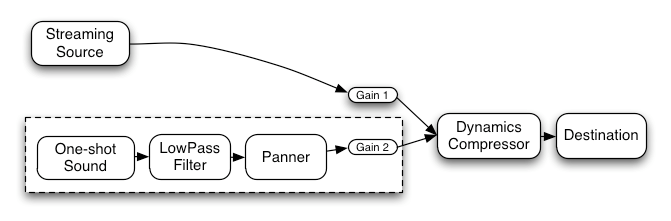

より複雑な例として、3つのソースとコンボリューションリバーブのセンド、最終出力段にダイナミクスコンプレッサーを使ったルーティング例は以下です:

let context; let compressor; let reverb; let source1, source2, source3; let lowpassFilter; let waveShaper; let panner; let dry1, dry2, dry3; let wet1, wet2, wet3; let mainDry; let mainWet; function setupRoutingGraph() { context= new AudioContext(); // Create the effects nodes. lowpassFilter= context. createBiquadFilter(); waveShaper= context. createWaveShaper(); panner= context. createPanner(); compressor= context. createDynamicsCompressor(); reverb= context. createConvolver(); // Create main wet and dry. mainDry= context. createGain(); mainWet= context. createGain(); // Connect final compressor to final destination. compressor. connect( context. destination); // Connect main dry and wet to compressor. mainDry. connect( compressor); mainWet. connect( compressor); // Connect reverb to main wet. reverb. connect( mainWet); // Create a few sources. source1= context. createBufferSource(); source2= context. createBufferSource(); source3= context. createOscillator(); source1. buffer= manTalkingBuffer; source2. buffer= footstepsBuffer; source3. frequency. value= 440 ; // Connect source1 dry1= context. createGain(); wet1= context. createGain(); source1. connect( lowpassFilter); lowpassFilter. connect( dry1); lowpassFilter. connect( wet1); dry1. connect( mainDry); wet1. connect( reverb); // Connect source2 dry2= context. createGain(); wet2= context. createGain(); source2. connect( waveShaper); waveShaper. connect( dry2); waveShaper. connect( wet2); dry2. connect( mainDry); wet2. connect( reverb); // Connect source3 dry3= context. createGain(); wet3= context. createGain(); source3. connect( panner); panner. connect( dry3); panner. connect( wet3); dry3. connect( mainDry); wet3. connect( reverb); // Start the sources now. source1. start( 0 ); source2. start( 0 ); source3. start( 0 ); }

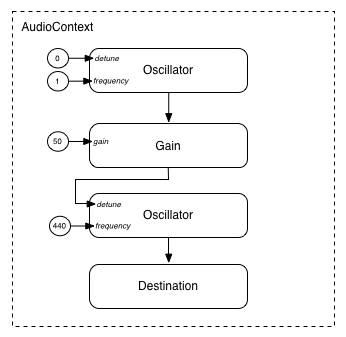

モジュラー型ルーティングでは、AudioNodeの出力を、

別のAudioParam

パラメータにルーティングして、異なるAudioNodeの挙動を制御することもできます。この場合、

ノードの出力は入力信号ではなく変調信号として機能します。

function setupRoutingGraph() { const context= new AudioContext(); // Create the low frequency oscillator that supplies the modulation signal const lfo= context. createOscillator(); lfo. frequency. value= 1.0 ; // Create the high frequency oscillator to be modulated const hfo= context. createOscillator(); hfo. frequency. value= 440.0 ; // Create a gain node whose gain determines the amplitude of the modulation signal const modulationGain= context. createGain(); modulationGain. gain. value= 50 ; // Configure the graph and start the oscillators lfo. connect( modulationGain); modulationGain. connect( hfo. detune); hfo. connect( context. destination); hfo. start( 0 ); lfo. start( 0 ); }

API概要

定義されるインターフェースは以下の通りです:

-

AudioContext インターフェースは、

AudioNode間の接続を表すオーディオ信号グラフを保持します。 -

AudioNodeインターフェースは、オーディオソース、オーディオ出力、中間処理モジュールを表します。AudioNodeはモジュラー方式で動的に接続可能です。AudioNodeはAudioContextの内部で存在します。 -

AnalyserNodeインターフェースは、音楽ビジュアライザーや他の可視化アプリケーション用のAudioNodeです。 -

AudioBufferインターフェースは、メモリ上のオーディオアセットを扱います。ワンショットサウンドや長いオーディオクリップを表現可能です。 -

AudioBufferSourceNodeインターフェースは、AudioNodeでAudioBufferからオーディオを生成します。 -

AudioDestinationNodeインターフェースは、すべてのレンダリングされたオーディオの最終出力先となるAudioNodeサブクラスです。 -

AudioParamインターフェースは、AudioNodeの音量など、個別の挙動を制御します。 -

AudioListenerインターフェースは、空間化のためのPannerNodeと連携します。 -

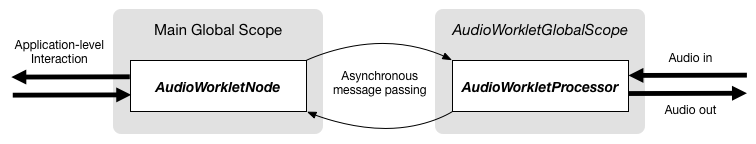

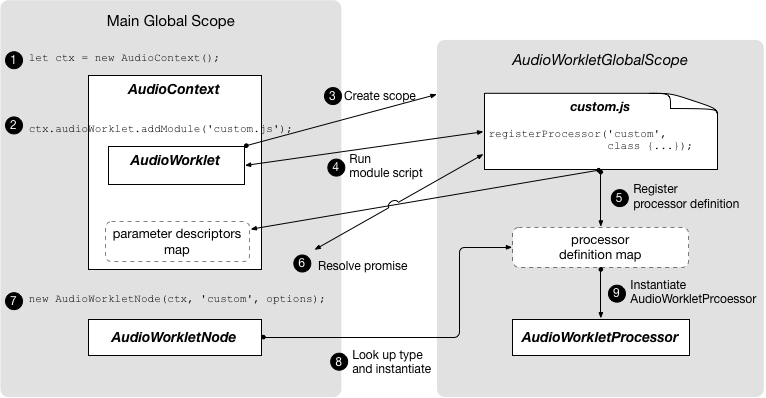

AudioWorkletインターフェースは、スクリプトで直接オーディオを処理するためのカスタムノードを生成するファクトリーです。 -

AudioWorkletGlobalScopeインターフェースは、AudioWorkletProcessorの処理スクリプトが実行されるコンテキストです。 -

AudioWorkletNodeインターフェースは、AudioWorkletProcessorで処理されるAudioNodeです。 -

AudioWorkletProcessorインターフェースは、オーディオワーカー内の単一ノードインスタンスを表します。 -

BiquadFilterNodeインターフェースは、以下のような一般的な低次数フィルターのAudioNodeです:-

ローパス

-

ハイパス

-

バンドパス

-

ローシェルフ

-

ハイシェルフ

-

ピーキング

-

ノッチ

-

オールパス

-

-

ChannelMergerNodeインターフェースは、複数のオーディオストリームのチャンネルを単一のストリームに合成するAudioNodeです。 -

ChannelSplitterNodeインターフェースは、ルーティンググラフ内のオーディオストリームの個々のチャンネルにアクセスするためのAudioNodeです。 -

ConstantSourceNodeインターフェースは、AudioNodeで名目上一定の出力値を生成し、AudioParamにより値の自動化を可能にします。 -

ConvolverNodeインターフェースは、コンサートホールなどのリアルタイム線形エフェクトを適用するAudioNodeです。 -

DynamicsCompressorNodeインターフェースは、ダイナミクスコンプレッションを行うAudioNodeです。 -

IIRFilterNodeインターフェースは、一般的なIIRフィルター用のAudioNodeです。 -

MediaElementAudioSourceNodeインターフェースは、AudioNodeで、audio、videoなどのメディア要素からのオーディオソースです。 -

MediaStreamAudioSourceNodeインターフェースは、AudioNodeで、MediaStream(ライブ入力やリモートピアなど)からのオーディオソースです。 -

MediaStreamTrackAudioSourceNodeインターフェースは、AudioNodeで、MediaStreamTrackからのオーディオソースです。 -

MediaStreamAudioDestinationNodeインターフェースは、AudioNodeで、リモートピアへ送信するMediaStreamへのオーディオ出力先です。 -

PannerNodeインターフェースは、3D空間でオーディオの空間化/位置指定を行うAudioNodeです。 -

PeriodicWaveインターフェースは、OscillatorNodeで使用するカスタム周期波形を指定します。 -

OscillatorNodeインターフェースは、周期波形を生成するAudioNodeです。 -

StereoPannerNodeインターフェースは、ステレオストリーム中のオーディオ入力のイコールパワー位置指定用AudioNodeです。 -

WaveShaperNodeインターフェースは、歪みや微妙なウォーミング効果のための非線形ウェーブシェイピングエフェクトを適用するAudioNodeです。

また、Web Audio APIから廃止予定であり現在は代替実装の経験を待っている機能もいくつか存在します:

-

ScriptProcessorNodeインターフェースは、スクリプトで直接オーディオを生成/処理するAudioNodeです。 -

AudioProcessingEventインターフェースは、ScriptProcessorNodeオブジェクトで使用されるイベント型です。

1. オーディオAPI

1.1.

BaseAudioContext

インターフェース

このインターフェースは、AudioNode

オブジェクト群とその接続を表します。任意の信号ルーティングをAudioDestinationNode

へ行うことができます。

ノードはコンテキストから生成され、相互接続されます。

BaseAudioContext

は直接インスタンス化されず、

代わりに具象インターフェースであるAudioContext

(リアルタイムレンダリング用)およびOfflineAudioContext

(オフラインレンダリング用)によって拡張されます。

BaseAudioContext

は内部スロット[[pending promises]]を持ち、これは初期状態では空の順序付きpromiseリストです。

各BaseAudioContext

は一意の

メディア要素イベントタスクソースを持ちます。

さらに、BaseAudioContext

は複数のプライベートスロット[[rendering thread state]]、

[[control thread state]]

を持ち、これらはAudioContextState

の値を取り、どちらも初期値は"suspended" です。また、プライベートスロット [[render quantum size]]は符号なし整数です。

enum {AudioContextState "suspended" ,"running" ,"closed" };

| 列挙値 | 説明 |

|---|---|

"suspended"

| このコンテキストは現在サスペンド状態です(コンテキスト時間は進行せず、オーディオハードウェアは電源切断・解放されている可能性があります)。 |

"running"

| オーディオが処理されています。 |

"closed"

| このコンテキストは解放され、オーディオ処理に使用できません。すべてのシステムオーディオリソースが解放されました。 |

enum {AudioContextRenderSizeCategory "default" ,"hardware" };

| 列挙型の説明 | |

|---|---|

"default"

| AudioContextのレンダリング量子サイズはデフォルト値128フレームです。 |

"hardware"

|

ユーザーエージェントが現在の構成に最適なレンダリング量子サイズを選択します。

注: これはホスト情報を公開し、フィンガープリントに利用される可能性があります。 |

callback DecodeErrorCallback =undefined (DOMException );error callback DecodeSuccessCallback =undefined (AudioBuffer ); [decodedData Exposed =Window ]interface BaseAudioContext :EventTarget {readonly attribute AudioDestinationNode destination ;readonly attribute float sampleRate ;readonly attribute double currentTime ;readonly attribute AudioListener listener ;readonly attribute AudioContextState state ;readonly attribute unsigned long renderQuantumSize ; [SameObject ,SecureContext ]readonly attribute AudioWorklet audioWorklet ;attribute EventHandler onstatechange ;AnalyserNode createAnalyser ();BiquadFilterNode createBiquadFilter ();AudioBuffer createBuffer (unsigned long ,numberOfChannels unsigned long ,length float );sampleRate AudioBufferSourceNode createBufferSource ();ChannelMergerNode createChannelMerger (optional unsigned long numberOfInputs = 6);ChannelSplitterNode createChannelSplitter (optional unsigned long numberOfOutputs = 6);ConstantSourceNode createConstantSource ();ConvolverNode createConvolver ();DelayNode createDelay (optional double maxDelayTime = 1.0);DynamicsCompressorNode createDynamicsCompressor ();GainNode createGain ();IIRFilterNode createIIRFilter (sequence <double >,feedforward sequence <double >);feedback OscillatorNode createOscillator ();PannerNode createPanner ();PeriodicWave createPeriodicWave (sequence <float >,real sequence <float >,imag optional PeriodicWaveConstraints = {});constraints ScriptProcessorNode createScriptProcessor (optional unsigned long bufferSize = 0,optional unsigned long numberOfInputChannels = 2,optional unsigned long numberOfOutputChannels = 2);StereoPannerNode createStereoPanner ();WaveShaperNode createWaveShaper ();Promise <AudioBuffer >decodeAudioData (ArrayBuffer ,audioData optional DecodeSuccessCallback ?,successCallback optional DecodeErrorCallback ?); };errorCallback

1.1.1. 属性

audioWorklet、 型: AudioWorklet、 読み取り専用-

Workletオブジェクトへのアクセスを許可し、AudioWorkletProcessorクラス定義を含むスクリプトを[HTML]およびAudioWorkletで定義されたアルゴリズムによりインポートできます。 currentTime、 型: double、読み取り専用-

これはコンテキストのレンダリンググラフで直近に処理されたオーディオブロックの最後のサンプルフレームに続くサンプルフレームの秒数です。レンダリンググラフがまだオーディオブロックを処理していない場合、

currentTimeの値は0です。currentTimeの時間座標系では、値0がグラフで最初に処理される最初のサンプルフレームに対応します。この座標系での経過時間は、BaseAudioContextにより生成されたオーディオストリームの経過時間に対応しますが、他のシステムクロックと同期しているとは限りません。(OfflineAudioContextでは、ストリームはデバイスで再生されないため、リアルタイムに近いものすらありません。)Web Audio APIのすべてのスケジュールされた時刻は

currentTimeの値を基準とします。BaseAudioContextが"running"状態のとき、 この属性の値は単調増加し、レンダリングスレッドにより均等な増分で更新され、レンダリング量子に対応します。したがって、runningなコンテキストではcurrentTimeはオーディオブロック処理に合わせて着実に増加し、常に次に処理されるオーディオブロックの開始時刻を表します。また、現在の状態でスケジュールされた変更が最も早く有効になる可能性のある時刻でもあります。currentTimeは返される前にコントロールスレッド上でアトミックに読み取られる必要があります。 destination、 型: AudioDestinationNode、読み取り専用-

1つの入力を持ち、すべてのオーディオの最終出力先を表す

AudioDestinationNodeです。通常は実際のオーディオハードウェアを表します。すべてのAudioNode(アクティブにオーディオをレンダリングしているもの)は直接または間接的にdestinationに接続されます。 listener、 型: AudioListener、 読み取り専用-

3D空間化に使用される

AudioListenerです。 onstatechange、 型: EventHandler-

AudioContextの状態が変化したとき(対応するpromiseが解決されたとき)、

BaseAudioContextにディスパッチされるイベント用のイベントハンドラを設定するためのプロパティです。イベント型はstatechangeです。Eventインターフェースを使うイベントがハンドラにディスパッチされ、AudioContextの状態を直接参照できます。新しく作成されたAudioContextは常にsuspended状態で開始し、状態が変化するたびにstatechangeイベントが発火されます。このイベントはcompleteイベントよりも前に発火されます。 sampleRate、 型: float、読み取り専用-

BaseAudioContextが処理するオーディオのサンプルレート(毎秒サンプルフレーム数)です。コンテキスト内のすべてのAudioNodeはこのレートで動作すると仮定されます。この仮定のもと、サンプルレート変換や「バリスピード」処理はリアルタイム処理ではサポートされません。 ナイキスト周波数はこのサンプルレート値の半分です。 state、 型: AudioContextState、読み取り専用-

BaseAudioContextの現在の状態を説明します。 この属性の取得は[[control thread state]]スロットの内容を返します。 renderQuantumSize、 型: unsigned long、読み取り専用-

この属性の取得は

[[render quantum size]]スロットの値を返します。

1.1.2. メソッド

createAnalyser()-

ファクトリメソッド。

AnalyserNodeを生成します。パラメータなし。返却型:AnalyserNode createBiquadFilter()-

ファクトリメソッド。

BiquadFilterNodeを生成し、代表的な二次フィルターのいずれかとして構成可能です。パラメータなし。返却型:BiquadFilterNode createBuffer(numberOfChannels, length, sampleRate)-

指定されたサイズのAudioBufferを生成します。バッファ内のオーディオデータはゼロ初期化(無音)されます。引数が負値、ゼロ、または規定範囲外の場合は、

NotSupportedError例外を必ず投げなければなりません。BaseAudioContext.createBuffer()メソッドの引数。 パラメータ 型 Nullable Optional 説明 numberOfChannelsunsigned long✘ ✘ バッファのチャンネル数を決定します。実装は少なくとも32チャンネルをサポートしなければなりません。 lengthunsigned long✘ ✘ バッファのサンプルフレーム数。最低でも1でなければなりません。 sampleRatefloat✘ ✘ バッファ内のリニアPCMオーディオデータのサンプルレート(毎秒サンプルフレーム数)。実装は少なくとも8000~96000の範囲をサポートしなければなりません。 返却型:AudioBuffer createBufferSource()-

ファクトリメソッド。

AudioBufferSourceNodeを生成します。パラメータなし。 createChannelMerger(numberOfInputs)-

ファクトリメソッド。

ChannelMergerNodeを生成します。IndexSizeErrorは、numberOfInputsが1未満、またはサポートされるチャンネル数を超える場合に必ず投げなければなりません。BaseAudioContext.createChannelMerger(numberOfInputs)メソッドの引数。 パラメータ 型 Nullable Optional 説明 numberOfInputsunsigned long✘ ✔ 入力数。最大32までサポート必須。省略時は 6が使用されます。返却型:ChannelMergerNode createChannelSplitter(numberOfOutputs)-

ファクトリメソッド。

ChannelSplitterNodeを生成します。IndexSizeErrorは、numberOfOutputsが1未満、またはサポートされるチャンネル数を超える場合に必ず投げなければなりません。BaseAudioContext.createChannelSplitter(numberOfOutputs)メソッドの引数。 パラメータ 型 Nullable Optional 説明 numberOfOutputsunsigned long✘ ✔ 出力数。最大32までサポート必須。省略時は 6が使用されます。返却型:ChannelSplitterNode createConstantSource()-

ファクトリメソッド。

ConstantSourceNodeを生成します。パラメータなし。返却型:ConstantSourceNode createConvolver()-

ファクトリメソッド。

ConvolverNodeを生成します。パラメータなし。返却型:ConvolverNode createDelay(maxDelayTime)-

ファクトリメソッド。

DelayNodeを生成します。初期デフォルトのディレイ時間は0秒です。BaseAudioContext.createDelay(maxDelayTime)メソッドの引数。 パラメータ 型 Nullable Optional 説明 maxDelayTimedouble✘ ✔ ディレイラインで許容される最大ディレイ時間(秒)。指定した場合、この値はゼロより大きく3分未満でなければならず、違反時は NotSupportedError例外を必ず投げなければなりません。省略時は1が使用されます。返却型:DelayNode createDynamicsCompressor()-

ファクトリメソッド。

DynamicsCompressorNodeを生成します。パラメータなし。 createGain()-

パラメータなし。返却型:

GainNode createIIRFilter(feedforward, feedback)-

BaseAudioContext.createIIRFilter()メソッドの引数。 パラメータ 型 Nullable Optional 説明 feedforwardsequence<double>✘ ✘ IIRフィルターの伝達関数のフィードフォワード(分子)係数の配列。最大長は20。すべての値がゼロの場合、 InvalidStateError必須で例外を投げます。NotSupportedError必須で、配列長が0または20超の場合に例外を投げます。feedbacksequence<double>✘ ✘ IIRフィルターの伝達関数のフィードバック(分母)係数の配列。最大長は20。配列の最初の要素が0の場合、 InvalidStateError必須で例外を投げます。NotSupportedError必須で、配列長が0または20超の場合に例外を投げます。返却型:IIRFilterNode createOscillator()-

ファクトリメソッド。

OscillatorNodeを生成します。パラメータなし。返却型:OscillatorNode createPanner()-

ファクトリメソッド。

PannerNodeを生成します。パラメータなし。返却型:PannerNode createPeriodicWave(real, imag, constraints)-

ファクトリメソッド。

PeriodicWaveを生成します。このメソッドを呼び出す際、以下の手順で実行します:-

realとimagの長さが一致しない場合、IndexSizeErrorを必ず投げます。 -

oを

PeriodicWaveOptions型の新しいオブジェクトとします。 -

oの

disableNormalization属性に、ファクトリメソッドに渡されたdisableNormalization属性の値をセットします。 -

新しい

PeriodicWavepを構築し、第一引数に本ファクトリメソッドが呼ばれたBaseAudioContextを、第二引数にoを渡します。 -

pを返します。

BaseAudioContext.createPeriodicWave()メソッドの引数。 パラメータ 型 Nullable Optional 説明 realsequence<float>✘ ✘ コサインパラメータの配列。詳細は realコンストラクタ引数の説明を参照。imagsequence<float>✘ ✘ サインパラメータの配列。詳細は imagコンストラクタ引数の説明を参照。constraintsPeriodicWaveConstraints✘ ✔ 指定しない場合、波形は正規化されます。指定した場合、 constraintsで与えられる値に従い正規化されます。返却型:PeriodicWave -

createScriptProcessor(bufferSize, numberOfInputChannels, numberOfOutputChannels)-

ファクトリメソッド。

ScriptProcessorNodeを生成します。このメソッドは非推奨であり、AudioWorkletNodeへの置き換えが予定されています。スクリプトによる直接音声処理用のScriptProcessorNodeを生成します。IndexSizeErrorは、bufferSizeやnumberOfInputChannelsやnumberOfOutputChannelsが有効範囲外の場合、必ず投げなければなりません。numberOfInputChannelsとnumberOfOutputChannelsの両方が0の場合は無効です。この場合はIndexSizeErrorを必ず投げなければなりません。BaseAudioContext.createScriptProcessor(bufferSize, numberOfInputChannels, numberOfOutputChannels)メソッドの引数。 パラメータ 型 Nullable Optional 説明 bufferSizeunsigned long✘ ✔ bufferSizeパラメータはバッファサイズ(サンプルフレーム単位)を決定します。指定しない場合や値が0の場合、実装側が最適なバッファサイズ(ノードの生存期間中はパワーオブ2で一定)を選択します。明示的に指定する場合は、256, 512, 1024, 2048, 4096, 8192, 16384いずれかでなければなりません。この値はaudioprocessイベントの発行頻度や、毎回処理するサンプルフレーム数を決定します。bufferSizeが小さいほどレイテンシが低くなります。値が大きいほど音切れやグリッチ回避に必要です。バッファサイズは指定せず実装に任せるのが推奨です。パワーオブ2以外の場合は、IndexSizeErrorを必ず投げなければなりません。numberOfInputChannelsunsigned long✘ ✔ ノード入力のチャンネル数。デフォルト値は2。最大32までサポート必須。 NotSupportedErrorをサポート外の場合は必ず投げなければなりません。numberOfOutputChannelsunsigned long✘ ✔ ノード出力のチャンネル数。デフォルト値は2。最大32までサポート必須。 NotSupportedErrorをサポート外の場合は必ず投げなければなりません。返却型:ScriptProcessorNode createStereoPanner()-

ファクトリメソッド。

StereoPannerNodeを生成します。パラメータなし。返却型:StereoPannerNode createWaveShaper()-

ファクトリメソッド。

WaveShaperNode(非線形歪み効果)を生成します。パラメータなし。返却型:WaveShaperNode decodeAudioData(audioData, successCallback, errorCallback)-

非同期的に、

ArrayBufferに格納されたオーディオファイルデータをデコードします。たとえばXMLHttpRequestのresponse属性でresponseTypeを"arraybuffer"に設定した後にロードしたArrayBufferなどが利用できます。オーディオファイルデータは、audio要素が対応する任意のフォーマットで構いません。decodeAudioData()に渡すバッファのcontent-typeは、[mimesniff]に記載されたスニッフィング手順で判定されます。主にpromiseのreturn値で扱いますが、コールバックパラメータはレガシー対応です。

破損ファイルについては作者への警告を推奨します(throwは後方互換性のため不可)。

注: 圧縮音声データのバイトストリームが破損していてもデコード可能な場合、実装は(例えば開発者ツールで)作者に警告することが推奨されます。decodeAudioDataが呼ばれた際、以下の手順をコントロールスレッドで実行する必要があります:-

thisの関連グローバルオブジェクトの関連付けられたDocumentが完全有効でない場合、"

InvalidStateError"DOMExceptionでrejectされたpromiseを返します。 -

promiseを新規生成。

-

-

promiseを

[[pending promises]]に追加。 -

audioDataArrayBufferをdetach。エラー時はstep 3へ。 -

デコード処理を他スレッドにキューイング。

-

-

それ以外の場合は以下のエラー処理:

-

errorを

DataCloneErrorとする。 -

promiseをerrorでrejectし、

[[pending promises]]から除去。 -

メディア要素タスクをキューイングし、

errorCallbackをerrorで呼び出す。

-

-

promiseを返す。

デコード処理を他スレッドにキューイングする場合、以下の手順をコントロールスレッド・レンダリングスレッド以外のデコードスレッドで実行する必要があります。注: 複数の

デコードスレッドが並列でdecodeAudioData処理可能。-

can decodeをtrueで初期化。

-

audioDataのMIMEタイプ判定。オーディオ・ビデオタイプパターン照合アルゴリズムがundefinedを返した場合、can decodeをfalseに。 -

can decodeがtrueなら、

audioDataをリニアPCMにデコード。失敗時はcan decodeをfalseに。 マルチトラックの場合は最初のトラックだけをデコード。注: より詳細なデコード制御が必要な場合は[WEBCODECS]を利用可能。

-

can decodeがfalseの場合、 メディア要素タスクをキューイングし、

-

errorを

DOMException(名前はEncodingError)に。-

promiseをerrorでrejectし、

[[pending promises]]から除去。

-

-

errorCallbackが存在する場合は、それをerrorで呼び出す。

-

-

それ以外の場合:

-

リザルト(デコード済みリニアPCM音声データ)を

BaseAudioContextのサンプルレートにリサンプル(異なる場合)。 -

-

リザルト(場合によりリサンプル済み)を含む

AudioBufferをbufferとする。 -

promiseをbufferでresolve。

-

successCallbackが存在する場合は、それをbufferで呼び出す。

-

-

BaseAudioContext.decodeAudioData()メソッドの引数。 パラメータ 型 Nullable Optional 説明 audioDataArrayBuffer✘ ✘ 圧縮音声データを含むArrayBuffer。 successCallbackDecodeSuccessCallback?✔ ✔ デコード終了時に呼ばれるコールバック関数。引数はデコード済みPCM音声データのAudioBuffer。 errorCallbackDecodeErrorCallback?✔ ✔ デコードエラー時に呼ばれるコールバック関数。 返却型:Promise<AudioBuffer> -

1.1.3. コールバック DecodeSuccessCallback()

のパラメータ

decodedData, 型AudioBuffer-

デコード済み音声データを含むAudioBufferです。

1.1.4. コールバック DecodeErrorCallback()

のパラメータ

error, 型DOMException-

デコード中に発生したエラーです。

1.1.5. ライフタイム

一度作成されたAudioContext

は、再生する音がなくなるか、ページが消えるまで音声の再生を続けます。

1.1.6. 内省やシリアル化プリミティブの欠如

Web Audio APIは発火して忘れる方式で音声ソースのスケジューリングを行います。つまり、ソースノードはAudioContext

のライフタイム中に各ノート用に生成され、グラフから明示的に削除されることはありません。これはシリアル化APIと互換性がなく、安定したノード集合がないためシリアル化できません。

さらに、内省APIがあると、コンテンツスクリプトがガベージコレクションの様子を観察できてしまいます。

1.1.7. BaseAudioContext

のサブクラスに関連するシステムリソース

サブクラスAudioContext

およびOfflineAudioContext

は高コストなオブジェクトと考えるべきです。これらのオブジェクトの作成は、ハイプライオリティなスレッドの生成や低レイテンシのシステムオーディオストリームの利用を伴い、エネルギー消費に影響します。通常、ドキュメント内で複数のAudioContext

を作成する必要はありません。

BaseAudioContext

サブクラスの構築や再開は、そのコンテキスト用のシステムリソースの取得を伴います。AudioContext

の場合、システムオーディオストリームの生成も必要です。これらの操作は、コンテキストが関連するオーディオグラフから出力の生成を開始するときに完了します。

さらに、ユーザーエージェントはAudioContext

の最大数を独自に定義でき、それを超えるAudioContext

の作成を試みると失敗し、NotSupportedErrorを投げます。

suspend

やclose

により、著者がスレッド、プロセス、オーディオストリームなどのシステムリソース解放を行えます。BaseAudioContext

のサスペンドは、実装が一部リソースを解放でき、resume

で後から再開可能です。AudioContext

のクローズは全リソースの解放を許可し、以後再利用や再開はできません。

注: 例えば、これはオーディオコールバックが定期的に発火するのを待ったり、ハードウェアが処理準備完了するのを待つことを含みます。

1.2. AudioContext

インターフェース

このインターフェースは、AudioDestinationNode

がリアルタイム出力デバイスにルーティングされ、ユーザーへ信号を出力するオーディオグラフを表します。ほとんどのユースケースでは、1文書につき1つのAudioContext

のみ使用されます。

enum {AudioContextLatencyCategory "balanced" ,"interactive" ,"playback" };

| 列挙値 | 説明 |

|---|---|

"balanced"

| オーディオ出力のレイテンシと消費電力のバランスを取る。 |

"interactive"

| グリッチを起こさず可能な限り低レイテンシでオーディオ出力を行う。これがデフォルト。 |

"playback"

| オーディオ出力のレイテンシよりも途切れのない持続的な再生を優先する。消費電力が最も低い。 |

enum {AudioSinkType "none" };

| 列挙値 | 説明 |

|---|---|

"none"

| オーディオグラフはオーディオ出力デバイスで再生せずに処理されます。 |

[Exposed =Window ]interface AudioContext :BaseAudioContext {constructor (optional AudioContextOptions contextOptions = {});readonly attribute double baseLatency ;readonly attribute double outputLatency ; [SecureContext ]readonly attribute (DOMString or AudioSinkInfo )sinkId ; [SecureContext ]readonly attribute AudioRenderCapacity renderCapacity ;attribute EventHandler onsinkchange ;attribute EventHandler onerror ;AudioTimestamp getOutputTimestamp ();Promise <undefined >resume ();Promise <undefined >suspend ();Promise <undefined >close (); [SecureContext ]Promise <undefined >((setSinkId DOMString or AudioSinkOptions ));sinkId MediaElementAudioSourceNode createMediaElementSource (HTMLMediaElement );mediaElement MediaStreamAudioSourceNode createMediaStreamSource (MediaStream );mediaStream MediaStreamTrackAudioSourceNode createMediaStreamTrackSource (MediaStreamTrack );mediaStreamTrack MediaStreamAudioDestinationNode createMediaStreamDestination (); };

AudioContext

が開始可能とは、ユーザーエージェントがコンテキスト状態を"suspended"

から

"running"へ遷移することを許可する場合を指します。

ユーザーエージェントはこの初回遷移を不許可にし、AudioContext

の関連グローバルオブジェクトがスティッキーアクティベーションを持つ場合のみ許可することがあります。

AudioContext

には以下の内部スロットがあります:

[[suspended by user]]-

コンテキストがユーザーコードによってサスペンドされているかを示す真偽値フラグです。 初期値は

falseです。 [[sink ID]]-

現在のオーディオ出力デバイスの識別子または情報を表す

DOMStringまたはAudioSinkInfoです。初期値は""(デフォルトのオーディオ出力デバイス)です。 [[pending resume promises]]

1.2.1. コンストラクター

AudioContext(contextOptions)-

現在の設定オブジェクトの関連グローバルオブジェクトの関連付けられたDocumentが完全有効でない場合は、 "

InvalidStateError" を投げて処理を中断します。AudioContextを作成する際、以下の手順を実行します:-

contextを新しい

AudioContextオブジェクトとして生成します。 -

contextの

[[control thread state]]をsuspendedに設定します。 -

contextの

[[rendering thread state]]をsuspendedに設定します。 -

messageChannelを新しい

MessageChannelとして生成します。 -

controlSidePortをmessageChannelの

port1属性値に設定します。 -

renderingSidePortをmessageChannelの

port2属性値に設定します。 -

serializedRenderingSidePortをStructuredSerializeWithTransfer(renderingSidePort, « renderingSidePort »)の結果とします。

-

audioWorkletのportをcontrolSidePortに設定します。 -

コントロールメッセージのキューイング を行い、AudioContextGlobalScopeにMessagePortをセットします。 引数はserializedRenderingSidePortです。

-

contextOptionsが指定されている場合、以下のサブ手順を実行します:-

sinkIdが指定されている場合、sinkIdをcontextOptions.の値として、以下のサブ手順を実行します:sinkId-

sinkIdと

[[sink ID]]の両方がDOMString型で、 かつ値が等しい場合はサブ手順を中断します。 -

sinkIdが

AudioSinkOptions型で、[[sink ID]]がAudioSinkInfo型で、 かつtypeの値が等しい場合はサブ手順を中断します。 -

validationResultをsink識別子の検証の返り値とします。

-

validationResultが

DOMException型の場合は、 validationResultで例外を投げてサブ手順を中断します。 -

sinkIdが

DOMString型の場合、[[sink ID]]をsinkIdに設定し、サブ手順を中断します。 -

sinkIdが

AudioSinkOptions型の場合、[[sink ID]]をtypeの値を使って新規作成したAudioSinkInfoインスタンスに設定します。

-

-

contextOptions.が指定されている場合は、latencyHintlatencyHintに記載された通り、contextの内部レイテンシを設定します。 -

contextOptions.が指定されている場合は、contextのsampleRatesampleRateをこの値に設定します。指定されていない場合は以下のサブ手順を実行します:-

sinkIdが空文字列、または

AudioSinkOptions型の場合は、 デフォルト出力デバイスのサンプルレートを使用し、サブ手順を中断します。 -

sinkIdが

DOMString型の場合は、 sinkIdで識別される出力デバイスのサンプルレートを使用し、サブ手順を中断します。

contextOptions.が出力デバイスのサンプルレートと異なる場合、ユーザーエージェントは必ず音声出力を出力デバイスのサンプルレートにリサンプルする必要があります。sampleRate注: リサンプリングが必要な場合、contextのレイテンシに大きく影響する場合があります。

-

-

-

contextを返します。

コントロールメッセージによる処理開始とは以下の手順です:-

documentを現在の設定オブジェクトの関連グローバルオブジェクトの関連付けられたDocumentとする。

-

[[sink ID]]に基づき、以下のオーディオ出力デバイス用にシステムリソースを取得する:-

空文字列ならデフォルトのオーディオ出力デバイス。

-

sinkIdで識別されるオーディオ出力デバイス。

-

リソース取得に失敗した場合は以下の手順:

-

documentが

"speaker-selection"という機能の利用を許可されていなければ、サブ手順を中断。 -

メディア要素タスクをキューイングして、

errorイベントをAudioContextに発火し、以下の手順を中断。

-

-

-

thisの

[[rendering thread state]]をrunningに設定。 -

メディア要素タスクをキューイングして、以下を実行:

-

state属性をAudioContextで"running"に設定。

-

注:

AudioContextを引数なしで構築しリソース取得に失敗した場合、ユーザーエージェントはオーディオ出力デバイスをエミュレートする機構で音声グラフをサイレントレンダリングする場合があります。コントロールメッセージでMessagePortをAudioWorkletGlobalScopeにセットする場合、以下の手順を レンダリングスレッドでserializedRenderingSidePortを使って実行します(current Realmに転送済)。-

deserializedPortをStructuredDeserialize(serializedRenderingSidePort, 現在のRealm)の結果とします。

-

portをdeserializedPortに設定します。

AudioContext.constructor(contextOptions) メソッドの引数。 パラメータ 型 Nullable Optional 説明 contextOptionsAudioContextOptions✘ ✔ AudioContextの構築方法を制御するユーザー指定オプション。 -

1.2.2. 属性

baseLatency、 型: double、読み取り専用-

これは

AudioContextがAudioDestinationNodeからオーディオサブシステムへ音声を渡す際に発生する処理レイテンシ(秒単位)を表します。他の処理による追加レイテンシ(AudioDestinationNode出力~オーディオハードウェア間)や、オーディオグラフ自体によるレイテンシは含みません。例えば、オーディオコンテキストが44.1kHzでデフォルトのレンダー量子サイズで動作し、

AudioDestinationNodeが内部でダブルバッファリングを実装し各レンダー量子毎に処理・出力できる場合、処理レイテンシは \((2\cdot128)/44100 = 5.805 \mathrm{ ms}\) 程度となります。 outputLatency、 型: double、読み取り専用-

オーディオ出力レイテンシの推定値(秒単位)。つまり、UAがホストシステムにバッファ再生を要求してから、バッファ内の最初のサンプルが実際にオーディオ出力デバイスで処理されるまでの間隔です。スピーカーやヘッドフォンなど、音響信号を生成するデバイスではこの時点はサンプルの音が出力されるタイミングです。

outputLatency属性値はプラットフォームや接続されているオーディオ出力デバイスのハードウェアに依存します。outputLatencyは、コンテキスト動作中や出力デバイスの変更時にも変化する場合があります。正確な同期が必要な場合はこの値を頻繁に取得するのが有効です。 renderCapacity、 型: AudioRenderCapacity、読み取り専用-

AudioContextに関連付けられたAudioRenderCapacityインスタンスを返します。 sinkId、 型:(DOMString or AudioSinkInfo)、読み取り専用-

[[sink ID]]内部スロットの値を返します。この属性は更新時にキャッシュされ、キャッシュ後は同じオブジェクトを返します。 onsinkchange、 型: EventHandler-

setSinkId()のイベントハンドラです。イベント型はsinkchangeで、出力デバイスの変更完了時に発火されます。注:

AudioContextの構築時の初回デバイス選択には発火されません。初期出力デバイスの準備確認にはstatechangeイベントが利用できます。 onerror、 型: EventHandler-

EventがAudioContextからディスパッチされたときのイベントハンドラです。 イベント型はerrorで、 以下の場合にUAがイベントを発火できます:-

選択したオーディオデバイスの初期化・有効化時に失敗した場合。

-

関連付けられたオーディオ出力デバイスが

AudioContext動作中に切断された場合。 -

OSからオーディオデバイスの異常が報告された場合。

-

1.2.3. メソッド

close()-

AudioContextを閉じて、使用中のシステムリソースを解放します。これによって すべてのAudioContext作成オブジェクトが自動的に解放されるわけではありませんが、AudioContextのcurrentTimeの進行を停止し、 音声データの処理を停止します。close が呼ばれたとき、次の手順を実行します:-

this の関連グローバルオブジェクトの関連付けられた Documentが完全有効でない場合、"

InvalidStateError" のDOMExceptionでrejectされた promiseを返します。 -

promise を新しい Promise とします。

-

AudioContext上の[[control thread state]]フラグがclosedの場合、InvalidStateErrorで promise を reject し、これらの手順を中断して promise を返します。 -

AudioContext上の[[control thread state]]フラグをclosedに設定します。 -

コントロールメッセージをキューイングして

AudioContextを閉じます。 -

promise を返します。

コントロールメッセージを実行してAudioContextを閉じるとは、 レンダリングスレッドで次の手順を実行することを意味します:-

システムリソースの解放を試みます。

-

[[rendering thread state]]をsuspendedに設定します。これによりレンダリングは停止します。 -

このコントロールメッセージがドキュメントのアンロードに対する反応として実行されている場合、 このアルゴリズムを中止します。

この場合、コントロールスレッドへ通知する必要はありません。 -

メディア要素タスクをキューイングして次の手順を実行します:

-

promise を resolve します。

-

AudioContextのstate属性がまだ "closed" でない場合:-

AudioContextのstate属性を "closed" に設定します。 -

メディア要素タスクをキューイングして、イベントを発火 名称

statechangeをAudioContextに対して行います。

-

-

AudioContextが閉じられると、 当該MediaStreamやHTMLMediaElementがAudioContextに接続されていた場合、その出力は無視されます。つまり、これらはスピーカーなどの出力デバイスに もはや出力を発生させません。挙動に柔軟性が必要な場合は、HTMLMediaElement.captureStream()の使用を検討してください。注:

AudioContextが閉じられた場合、実装はサスペンド時よりも積極的にリソースを解放することを選択できます。パラメータなし。 -

createMediaElementSource(mediaElement)-

MediaElementAudioSourceNodeを、 指定されたHTMLMediaElementから作成します。 このメソッド呼び出しの結果、当該HTMLMediaElementからの 音声再生は、AudioContextの処理グラフへと再ルーティングされます。AudioContext.createMediaElementSource() メソッドの引数。 パラメータ 型 Nullable Optional 説明 mediaElementHTMLMediaElement✘ ✘ 再ルーティングされるメディア要素。 createMediaStreamDestination()-

MediaStreamAudioDestinationNodeを作成します。パラメータなし。 createMediaStreamSource(mediaStream)-

MediaStreamAudioSourceNodeを作成します。AudioContext.createMediaStreamSource() メソッドの引数。 パラメータ 型 Nullable Optional 説明 mediaStreamMediaStream✘ ✘ ソースとして機能するメディアストリーム。 createMediaStreamTrackSource(mediaStreamTrack)-

MediaStreamTrackAudioSourceNodeを作成します。AudioContext.createMediaStreamTrackSource() メソッドの引数。 パラメータ 型 Nullable Optional 説明 mediaStreamTrackMediaStreamTrack✘ ✘ ソースとして機能する MediaStreamTrack。そのkind属性の値は"audio"と等しくなければならず、そうでない場合はInvalidStateError例外を必ず投げます。 getOutputTimestamp()-

新しい

AudioTimestampインスタンスを返します。 これはコンテキストに関する2つの関連するオーディオストリーム位置を含みます。contextTimeメンバーは、オーディオ出力デバイスによって現在レンダリングされているサンプルフレームの時刻(すなわち出力オーディオストリームの位置)を、 コンテキストのcurrentTimeと同じ単位および原点で保持します。performanceTimeメンバーは、保存されたcontextTimeに対応するサンプルフレームがオーディオ出力デバイスによってレンダリングされた時刻を、performance.now()([hr-time-3] 参照)と同じ単位および原点で推定した値を保持します。コンテキストのレンダリンググラフがまだオーディオブロックを処理していない場合、

getOutputTimestamp呼び出しは、両方のメンバーがゼロを含むAudioTimestampインスタンスを返します。コンテキストのレンダリンググラフがオーディオブロックの処理を開始した後は、

currentTime属性の値は常に、contextTimeの値(getOutputTimestampの呼び出しで取得)を上回ります。getOutputTimestampから返される値を利用して、やや先のコンテキスト時間に対するパフォーマンスタイムの推定値を得られます:function outputPerformanceTime( contextTime) { const timestamp= context. getOutputTimestamp(); const elapsedTime= contextTime- timestamp. contextTime; return timestamp. performanceTime+ elapsedTime* 1000 ; } 上の例では、推定の精度は引数の値が現在の出力オーディオストリーム位置にどれだけ近いかに依存します。与えた

contextTimeがtimestamp.contextTimeに近いほど、得られる推定の精度は高くなります。注: コンテキストの

currentTimeと、contextTime(getOutputTimestamp呼び出しで取得)の差は、 信頼できる出力レイテンシの推定とは見なせません。これはcurrentTimeが不均一な時間間隔で増分されうるためであり、代わりにoutputLatency属性を使用すべきです。パラメータなし。返却型:AudioTimestamp resume()-

サスペンドされている場合に、

AudioContextのcurrentTimeの進行を再開します。resume が呼ばれたとき、次の手順を実行します:-

this の関連グローバルオブジェクトの関連付けられた Documentが完全有効でない場合、"

InvalidStateError" のDOMExceptionでrejectされた promiseを返します。 -

promise を新しい Promise とします。

-

AudioContext上の[[control thread state]]がclosedの場合、InvalidStateErrorで promise を reject し、これらの手順を中断して promise を返します。 -

[[suspended by user]]をfalseに設定します。 -

contextが開始可能でない場合、promiseを

[[pending promises]]および[[pending resume promises]]に追加し、これらの手順を中止してpromiseを返します。 -

AudioContext上の[[control thread state]]をrunningに設定します。 -

コントロールメッセージをキューイングして

AudioContextの再開を行います。 -

promise を返します。

コントロールメッセージを実行してAudioContextを再開するとは、 レンダリングスレッドで次の手順を実行することを意味します:-

システムリソースの取得を試みます。

-

AudioContext上の[[rendering thread state]]をrunningに設定します。 -

オーディオグラフのレンダリングを開始します。

-

失敗した場合、 メディア要素タスクをキューイングして次の手順を実行します:

-

[[pending resume promises]]のすべての promise を順に reject し、その後[[pending resume promises]]をクリアします。 -

加えて、それらの promise を

[[pending promises]]から削除します。

-

-

メディア要素タスクをキューイングして次の手順を実行します:

-

[[pending resume promises]]のすべての promise を順に resolve します。 -

[[pending resume promises]]をクリアし、さらにそれらの promise を[[pending promises]]から削除します。 -

promise を resolve します。

-

AudioContextのstate属性がまだ "running" でない場合:-

AudioContextのstate属性を "running" に設定します。 -

メディア要素タスクをキューイングして、 イベントを発火 名称

statechangeをAudioContextに対して行います。

-

-

パラメータなし。 -

suspend()-

AudioContextのcurrentTimeの進行をサスペンドし、すでに処理済みの現在のコンテキスト処理ブロックが出力先へ再生されることを許可した後、システムがオーディオハードウェアに対する占有を解放できるようにします。 これはアプリケーションがしばらくの間AudioContextを必要としないことが分かっている場合に、 当該AudioContextに関連するシステムリソースの一時的な解放を行うのに有用です。promise はフレームバッファが空(ハードウェアへ引き渡された)になったときに解決され、 すでにコンテキストがsuspendedの場合は即座に(他の効果なしで)解決されます。コンテキストが閉じられている場合は promise は reject されます。suspend が呼ばれたとき、次の手順を実行します:-

this の関連グローバルオブジェクトの関連付けられた Documentが完全有効でない場合、"

InvalidStateError" のDOMExceptionでrejectされた promiseを返します。 -

promise を新しい Promise とします。

-

AudioContext上の[[control thread state]]がclosedの場合、InvalidStateErrorで promise を reject し、これらの手順を中断して promise を返します。 -

promise を

[[pending promises]]に追加します。 -

[[suspended by user]]をtrueに設定します。 -

AudioContext上の[[control thread state]]をsuspendedに設定します。 -

コントロールメッセージをキューイングして

AudioContextをサスペンドします。 -

promise を返します。

コントロールメッセージを実行してAudioContextをサスペンドするとは、 レンダリングスレッドで次の手順を実行することを意味します:-

システムリソースの解放を試みます。

-

AudioContext上の[[rendering thread state]]をsuspendedに設定します。 -

メディア要素タスクをキューイングして次の手順を実行します:

-

promise を resolve します。

-

AudioContextのstate属性がまだ "suspended" でない場合:-

AudioContextのstate属性を "suspended" に設定します。 -

メディア要素タスクをキューイングして、 イベントを発火 名称

statechangeをAudioContextに対して行います。

-

-

AudioContextがサスペンドされている間、MediaStreamの出力は無視されます。 つまり、メディアストリームのリアルタイム性によりデータは失われます。HTMLMediaElementも同様に、システムが再開されるまで出力は無視されます。AudioWorkletNodeとScriptProcessorNodeは、サスペンド中は処理ハンドラの呼び出しが行われなくなりますが、コンテキストの再開時に処理も再開します。AnalyserNodeのウィンドウ関数の観点では、 データは連続したストリームとみなされます。つまりresume()/suspend()はAnalyserNodeのデータストリーム中に無音を発生させません。 特に、AudioContextがサスペンドされているときにAnalyserNodeの関数を繰り返し呼び出すと、 同じデータを返さなければなりません。パラメータなし。 -

setSinkId((DOMString or AudioSinkOptions) sinkId)-

出力デバイスの識別子を設定します。このメソッドが呼び出されたとき、ユーザーエージェントは次の手順を実行しなければなりません:

-

sinkId をこのメソッドの第1引数とします。

-

sinkId が

[[sink ID]]と等しい場合、promise を返し、即座に resolve してこれらの手順を中断します。 -

validationResult を sink 識別子の検証(引数 sinkId)の戻り値とします。

-

validationResult が

nullでない場合、validationResult で reject された promise を返して、これらの手順を中断します。 -

p を新しい promise とします。

-

p と sinkId を伴うコントロールメッセージを送って、処理を開始します。

-

p を返します。

setSinkId()実行中に処理を開始するためにコントロールメッセージを送るとは、 次の手順を実行することを意味します:-

p をこのアルゴリズムに渡された promise とします。

-

sinkId をこのアルゴリズムに渡された sink 識別子とします。

-

sinkId と

[[sink ID]]の両方がDOMString型で、 かつ互いに等しい場合、 メディア要素タスクをキューイングして p を resolve し、これらの手順を中断します。 -

sinkId が

AudioSinkOptions型で、[[sink ID]]がAudioSinkInfo型であり、 さらに sinkId のtypeとtype([[sink ID]]内)が等しい場合、 メディア要素タスクをキューイングして p を resolve し、これらの手順を中断します。 -

wasRunning を true とします。

-

AudioContext上の[[rendering thread state]]が"suspended"の場合、wasRunning を false に設定します。 -

現在のレンダー量子の処理後にレンダラーを一時停止します。

-

システムリソースの解放を試みます。

-

wasRunning が true の場合:

-

AudioContext上の[[rendering thread state]]を"suspended"に設定します。 -

メディア要素タスクをキューイングして次の手順を実行します:

-

AudioContextのstate属性がまだ "suspended" でない場合:-

AudioContextのstate属性を "suspended" に設定します。 -

イベントを発火 名称

statechangeを、関連するAudioContextに対して行います。

-

-

-

-

[[sink ID]]に基づいて、レンダリングに使用する次のオーディオ出力デバイス用のシステムリソースを取得することを試みます:-

空文字列の場合はデフォルトのオーディオ出力デバイス。

-

[[sink ID]]で識別されるオーディオ出力デバイス。

失敗した場合、"

InvalidAccessError" で p を reject し、以降の手順を中断します。 -

-

メディア要素タスクをキューイングして次の手順を実行します:

-

sinkId が

DOMString型である場合、[[sink ID]]を sinkId に設定します。これらの手順を中断します。 -

sinkId が

AudioSinkOptions型で、[[sink ID]]がDOMString型である場合、[[sink ID]]を、sinkId のtypeの値で作成した新しいAudioSinkInfoインスタンスに設定します。 -

sinkId が

AudioSinkOptions型で、[[sink ID]]がAudioSinkInfo型である場合、type([[sink ID]]内)を sinkId のtypeの値に設定します。 -

p を resolve します。

-

イベントを発火 名称

sinkchangeを、関連するAudioContextに対して行います。

-

-

wasRunning が true の場合:

-

AudioContext上の[[rendering thread state]]を"running"に設定します。 -

メディア要素タスクをキューイングして次の手順を実行します:

-

AudioContextのstate属性がまだ "running" でない場合:-

AudioContextのstate属性を "running" に設定します。 -

イベントを発火 名称

statechangeを、関連するAudioContextに対して行います。

-

-

-

-

1.2.4.

sinkIdの検証

このアルゴリズムは、sinkIdを変更するために提供された情報を検証するために使用されます:

-

documentを、現在の設定オブジェクトの関連付けられたDocumentとします。

-

sinkIdArgをこのアルゴリズムに渡された値とします。

-

documentが

"speaker-selection"という機能の利用を許可されていない場合は、 名前が"NotAllowedError" の新しいDOMExceptionを返します。 -

sinkIdArgが

DOMString型であり、空文字列でない、またはenumerateDevices()の結果として識別されるオーディオ出力デバイスのいずれにも一致しない場合は、 名前が"NotFoundError" の新しいDOMExceptionを返します。 -

nullを返します。

1.2.5. AudioContextOptions

AudioContextOptions

辞書は、AudioContextのユーザー指定オプションを指定するために使用されます。

dictionary AudioContextOptions { (AudioContextLatencyCategory or double )latencyHint = "interactive";float sampleRate ; (DOMString or AudioSinkOptions )sinkId ; (AudioContextRenderSizeCategory or unsigned long )renderSizeHint = "default"; };

1.2.5.1. 辞書 AudioContextOptions

メンバー

latencyHint、 型:(AudioContextLatencyCategory or double)、デフォルトは"interactive"-

再生の種類を識別し、オーディオ出力レイテンシと消費電力のトレードオフに影響します。

latencyHintの推奨値はAudioContextLatencyCategoryの値ですが、細かい制御が必要な場合は秒数(double型)も指定可能です。ブラウザはこの数値を適切に解釈します。実際に使用されるレイテンシはbaseLatency属性で示されます。 sampleRate、 型: float-

作成される

AudioContextのsampleRateをこの値に設定します。サポートされる値はAudioBufferのサンプルレートと同じです。 指定したサンプルレートがサポートされていない場合はNotSupportedError例外を必ず投げなければなりません。sampleRateを指定しない場合、このAudioContext用の出力デバイスの推奨サンプルレートが使用されます。 sinkId、 型:(DOMString or AudioSinkOptions)-

オーディオ出力デバイスの識別子または関連情報。詳細は

sinkId参照。 renderSizeHint、 型:(AudioContextRenderSizeCategory or unsigned long)、デフォルトは"default"-

整数を指定した場合は特定のレンダー量子サイズを要求できます。何も指定しない場合や

"default"の場合はデフォルト(128フレーム)を使用します。"hardware"の場合はユーザーエージェントが最適なレンダー量子サイズを選択します。これはヒントであり、必ずしも反映されるとは限りません。

1.2.6.

AudioSinkOptions

AudioSinkOptions

辞書は、sinkId用のオプション指定に使用されます。

dictionary AudioSinkOptions {required AudioSinkType type ; };

1.2.6.1. 辞書 AudioSinkOptions

メンバー

type、 型: AudioSinkType-

デバイス種別を指定するための

AudioSinkTypeの値。

1.2.7. AudioSinkInfo

AudioSinkInfo

インターフェースは、sinkId経由で現在のオーディオ出力デバイス情報を取得するために使用されます。

[Exposed =Window ]interface AudioSinkInfo {readonly attribute AudioSinkType type ; };

1.2.7.1. 属性

type、 型: AudioSinkType、読み取り専用-

デバイス種別を表す

AudioSinkTypeの値。

1.2.8. AudioTimestamp

dictionary AudioTimestamp {double contextTime ;DOMHighResTimeStamp performanceTime ; };

1.2.8.1. 辞書 AudioTimestamp

メンバー

contextTime、 型: double-

BaseAudioContextの

currentTimeの時間座標系上の時点を表します。 performanceTime、 型: DOMHighResTimeStamp-

Performanceインターフェース実装の時間座標系上の時点を表します([hr-time-3]参照)。

1.2.9. AudioRenderCapacity

[Exposed =Window ]interface :AudioRenderCapacity EventTarget {undefined start (optional AudioRenderCapacityOptions = {});options undefined stop ();attribute EventHandler onupdate ; };

このインターフェースはAudioContext

のレンダリング性能指標を提供します。指標計算のため、レンダラーは負荷値をシステムレベルオーディオコールバックごとに収集します。

1.2.9.1. 属性

onupdate、 型: EventHandler-

このイベントハンドラのイベント型は

updateです。 ハンドラにディスパッチされるイベントはAudioRenderCapacityEventインターフェースを使用します。

1.2.9.2. メソッド

start(options)-

指標収集・分析を開始します。指定した更新間隔で

AudioRenderCapacityEventを使い、AudioRenderCapacityに対してupdateイベントを繰り返し発火します。 更新間隔はAudioRenderCapacityOptionsで指定します。 stop()-

指標収集・分析を停止します。また、

updateイベントのディスパッチも停止します。

1.2.10.

AudioRenderCapacityOptions

AudioRenderCapacityOptions

辞書は、AudioRenderCapacity用のユーザーオプション指定に利用できます。

dictionary {AudioRenderCapacityOptions double updateInterval = 1; };

1.2.10.1. 辞書 AudioRenderCapacityOptions

メンバー

updateInterval、 型: double、デフォルトは1-

AudioRenderCapacityEventのディスパッチ間隔(秒単位)。 負荷値はシステムレベルオーディオコールバックごとに計算され、指定された間隔期間中に複数の負荷値が収集されます。例えば、レンダラーが48kHzのサンプルレートで動作し、システムレベルオーディオコールバックのバッファサイズが192フレームの場合、1秒間隔で250個の負荷値が収集されます。指定値がシステムレベルオーディオコールバックの期間より小さい場合、

NotSupportedErrorが投げられます。

1.2.11. AudioRenderCapacityEvent

[Exposed =Window ]interface :AudioRenderCapacityEvent Event {(constructor DOMString ,type optional AudioRenderCapacityEventInit = {});eventInitDict readonly attribute double timestamp ;readonly attribute double averageLoad ;readonly attribute double peakLoad ;readonly attribute double underrunRatio ; };dictionary :AudioRenderCapacityEventInit EventInit {double = 0;timestamp double = 0;averageLoad double = 0;peakLoad double = 0; };underrunRatio

1.2.11.1. 属性

timestamp、 型: double、読み取り専用-

データ収集期間の開始時刻(関連

AudioContextのcurrentTime基準)。 averageLoad、 型: double、読み取り専用-

指定した更新間隔内で収集された負荷値の平均。精度は1/100単位まで。

peakLoad、 型: double、読み取り専用-

指定した更新間隔内で収集された負荷値の最大値。精度も1/100単位まで。

underrunRatio、 型: double、読み取り専用-

指定した更新間隔内において、バッファアンダーラン(負荷値が1.0を超えた場合)の回数とシステムレベルオーディオコールバック総数の比率。

\(u\) をバッファアンダーラン回数、\(N\) を指定した更新間隔内のシステムレベルオーディオコールバック総数とした場合、バッファアンダーラン比は以下の通り:

-

\(u\) = 0 の場合は 0.0。

-

それ以外の場合は \(u/N\) を計算し、最も近い100分位の天井値を取る。

-

1.3. OfflineAudioContext

インターフェース

OfflineAudioContext

は、BaseAudioContext

の特殊な型であり、レンダリングやミックスダウンを(リアルタイムより)高速に行うためのものです。オーディオハードウェアへはレンダリングせず、可能な限り高速にレンダリングを行い、レンダリング結果をAudioBufferとしてpromiseで返します。

[Exposed =Window ]interface OfflineAudioContext :BaseAudioContext {constructor (OfflineAudioContextOptions contextOptions );constructor (unsigned long numberOfChannels ,unsigned long length ,float sampleRate );Promise <AudioBuffer >startRendering ();Promise <undefined >resume ();Promise <undefined >suspend (double );suspendTime readonly attribute unsigned long length ;attribute EventHandler oncomplete ; };

1.3.1. コンストラクター

OfflineAudioContext(contextOptions)-

現在の設定オブジェクトの関連グローバルオブジェクトの関連付けられたDocumentが完全有効でない場合は、

cを新しいInvalidStateErrorを投げて処理を中断します。OfflineAudioContextオブジェクトとします。 cを以下のように初期化します:-

c上の

[[control thread state]]を"suspended"に設定します。 -

c上の

[[rendering thread state]]を"suspended"に設定します。 -

この

OfflineAudioContextの[[render quantum size]]をrenderSizeHintの値で決定します:-

値が

"default"または"hardware"の場合は、[[render quantum size]]プライベートスロットを128に設定します。 -

整数値を渡した場合は、ユーザーエージェントがこの値を反映するか決定し、

[[render quantum size]]プライベートスロットに設定します。

-

-

AudioDestinationNodeをcontextOptions.numberOfChannelsでchannelCountを設定して構築します。 -

messageChannelを新しい

MessageChannelとします。 -

controlSidePortをmessageChannelの

port1属性値にします。 -

renderingSidePortをmessageChannelの

port2属性値にします。 -

serializedRenderingSidePortをStructuredSerializeWithTransfer(renderingSidePort, « renderingSidePort »)の結果にします。

-

この

audioWorkletのport属性をcontrolSidePortに設定します。 -

コントロールメッセージのキューイングを行い、 AudioContextGlobalScopeにMessagePortをセットします。 引数はserializedRenderingSidePort。

OfflineAudioContext.constructor(contextOptions) メソッドの引数。 パラメータ 型 Nullable Optional 説明 contextOptionsこのコンテキストを構築するために必要な初期パラメータ。 -

OfflineAudioContext(numberOfChannels, length, sampleRate)-

OfflineAudioContextは AudioContext.createBuffer と同じ引数で構築可能です。いずれかの引数が負、ゼロ、あるいは規定範囲外の場合はNotSupportedError例外を必ず投げなければなりません。OfflineAudioContextは、以下の呼び出しと同じように構築されます:

new OfflineAudioContext({ numberOfChannels: numberOfChannels, length: length, sampleRate: sampleRate}) が呼ばれた場合と同等です。

OfflineAudioContext.constructor(numberOfChannels, length, sampleRate)メソッドの引数。 パラメータ 型 Nullable Optional 説明 numberOfChannelsunsigned long✘ ✘ バッファのチャンネル数を決定します。対応チャンネル数は createBuffer()参照。lengthunsigned long✘ ✘ バッファのサイズ(サンプルフレーム数)。 sampleRatefloat✘ ✘ バッファ内のリニアPCMオーディオデータのサンプルレート(秒間サンプルフレーム数)。有効な値は createBuffer()参照。

1.3.2. 属性

length、 型: unsigned long、読み取り専用-

バッファのサイズ(サンプルフレーム数)。これはコンストラクタの

lengthパラメータと同じ値です。 oncomplete、 型: EventHandler-

このイベントハンドラのイベント型は

completeです。ハンドラにディスパッチされるイベントはOfflineAudioCompletionEventインターフェースを使用します。これはOfflineAudioContext上で最後に発火されるイベントです。

1.3.3. メソッド

startRendering()-

現在の接続およびスケジュール済みの変更に基づいて、オーディオのレンダリングを開始します。

レンダリングされたオーディオデータを取得する主な方法はプロミスの返り値ですが、インスタンスはレガシー理由により

completeというイベントも発火します。[[rendering started]]は、このOfflineAudioContextの内部スロットである。 このスロットを false に初期化する。startRenderingが呼び出されたとき、以下の手順を コントロールスレッド で実行しなければならない:- this の 関連グローバルオブジェクト の 関連付けられた Document が 完全にアクティブ でない場合、プロミスを拒否して返す。理由は "

InvalidStateError"DOMExceptionである。 [[rendering started]]スロットがOfflineAudioContext上で true の場合、プロミスをInvalidStateErrorで拒否して返し、これらの手順を中断する。[[rendering started]]スロットをOfflineAudioContext上で true に設定する。- promise を新しいプロミスとして作成する。

AudioBufferを新規作成し、チャンネル数・長さ・サンプルレートはこのインスタンスのコンストラクタでcontextOptionsパラメータに渡されたnumberOfChannels・length・sampleRateと同じ値で設定する。 このバッファを内部スロット[[rendered buffer]]に割り当てる。- 前述の

AudioBufferコンストラクタ呼び出し中に例外が発生した場合、promise をその例外で拒否する。 - バッファが正常に構築された場合、オフラインレンダリングを開始する。

- promise を

[[pending promises]]に追加する。 - promise を返す。

オフラインレンダリングを開始 するには、以下の手順をこのために作成された レンダリングスレッド で実行しなければならない。- 現在の接続とスケジュール済みの変更に基づいて、

lengthサンプルフレーム分のオーディオを[[rendered buffer]]にレンダリングする。 - 各 レンダー量子

において、

suspendが必要か確認する。 - サスペンドされたコンテキストが再開された場合、バッファのレンダリングを続行する。

-

レンダリング完了後、メディア要素タスクをキューに追加し、以下の手順を実行する:

startRendering()で作成した promise を[[rendered buffer]]で解決する。- メディア要素タスクをキューに追加し、complete イベントを発火する。イベントは

OfflineAudioContext上で発火され、OfflineAudioCompletionEventを使い、renderedBufferプロパティを[[rendered buffer]]に設定する。

パラメータなし。返り値型:Promise<AudioBuffer> - this の 関連グローバルオブジェクト の 関連付けられた Document が 完全にアクティブ でない場合、プロミスを拒否して返す。理由は "

resume()-

OfflineAudioContextのcurrentTimeがサスペンドされている場合、その進行を再開します。resume が呼び出されたとき、以下の手順を実行する:-

this の 関連グローバルオブジェクト の 関連付けられた Document が 完全にアクティブ でない場合、プロミスを拒否して返す。理由は "

InvalidStateError"DOMExceptionである。 -

promise を新しい Promise として作成する。

-

次のいずれかの条件が true の場合、これらの手順を中断し promise を

InvalidStateErrorで拒否する:-

[[control thread state]]がOfflineAudioContext上でclosedである。 -

[[rendering started]]スロットがOfflineAudioContext上で false である。

-

-

[[control thread state]]フラグをOfflineAudioContext上でrunningに設定する。 -

promise を返す。

コントロールメッセージを実行してOfflineAudioContextを再開するには、以下の手順を レンダリングスレッド で実行する:-

[[rendering thread state]]をOfflineAudioContext上でrunningに設定する。 -

オーディオグラフのレンダリング を開始する。

-

失敗した場合は、メディア要素タスクをキューに追加し、promise を拒否して残りの手順を中断する。

-

メディア要素タスクをキューに追加して以下の手順を実行する:

-

promise を解決する。

-

state属性がOfflineAudioContext上で まだ "running" でない場合:-

state属性をOfflineAudioContext上で "running" に設定する。 -

メディア要素タスクをキューに追加し、statechange イベントを発火する。イベントは

OfflineAudioContext上で発火される。

-

-

パラメータなし。 -

suspend(suspendTime)-

指定した時間にオーディオコンテキストの時間進行のサスペンドをスケジュールし、プロミスを返します。これは

OfflineAudioContextのオーディオグラフを同期的に操作する際に一般的に便利です。サスペンドの最大精度は レンダー量子 のサイズであり、指定したサスペンド時間は最も近い レンダー量子 境界に切り上げられます。そのため、同じ量子化フレームで複数のサスペンドをスケジュールすることはできません。また、正確なサスペンドのためにはコンテキストが実行中でない間にスケジューリングするべきです。

OfflineAudioContext.suspend() メソッドの引数 パラメータ 型 Nullable Optional 説明 suspendTimedouble✘ ✘ 指定した時間でレンダリングのサスペンドをスケジュールします。時間は量子化され、レンダー量子のサイズに切り上げられます。量子化されたフレーム番号が - 負の値である場合

- 現在時刻以下である場合

- 合計レンダー期間以上である場合

- 同じ時間に他の suspend がスケジュールされている場合

InvalidStateErrorで拒否されます。

1.3.4. OfflineAudioContextOptions

これは OfflineAudioContext

の構築時に使用するオプションを指定します。

dictionary OfflineAudioContextOptions {unsigned long numberOfChannels = 1;required unsigned long length ;required float sampleRate ; (AudioContextRenderSizeCategory or unsigned long )renderSizeHint = "default"; };

1.3.4.1. 辞書 OfflineAudioContextOptions

のメンバー

length, 型 unsigned long-

レンダリングされた

AudioBufferのサンプルフレーム数です。 numberOfChannels, 型 unsigned long, デフォルト値は1-

この

OfflineAudioContextのチャンネル数です。 sampleRate, 型 float-

この

OfflineAudioContextのサンプルレートです。 renderSizeHint, 型(AudioContextRenderSizeCategory or unsigned long), デフォルト値は"default"-

この

OfflineAudioContextのレンダー量子サイズのヒントです。

1.3.5.

OfflineAudioCompletionEvent

インターフェース

これは Event

オブジェクトであり、レガシー理由により OfflineAudioContext

にディスパッチされます。

[Exposed =Window ]interface OfflineAudioCompletionEvent :Event {(constructor DOMString ,type OfflineAudioCompletionEventInit );eventInitDict readonly attribute AudioBuffer renderedBuffer ; };

1.3.5.1. 属性

renderedBuffer, 型 AudioBuffer, 読み取り専用-

レンダリングされたオーディオデータを含む

AudioBufferです。

1.3.5.2.

OfflineAudioCompletionEventInit

dictionary OfflineAudioCompletionEventInit :EventInit {required AudioBuffer renderedBuffer ; };

1.3.5.2.1. 辞書 OfflineAudioCompletionEventInit

のメンバー

renderedBuffer, 型 AudioBuffer-

イベントの

renderedBuffer属性に割り当てる値です。

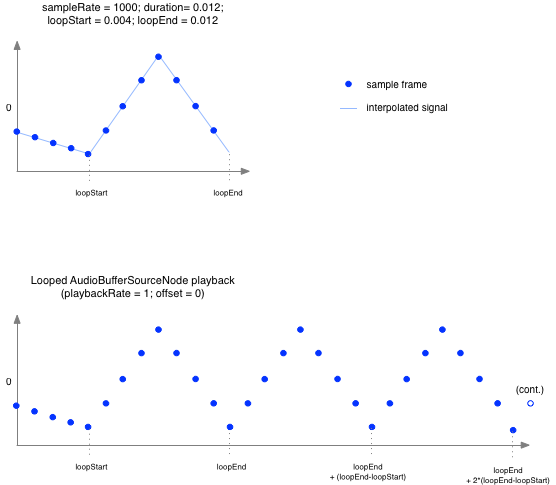

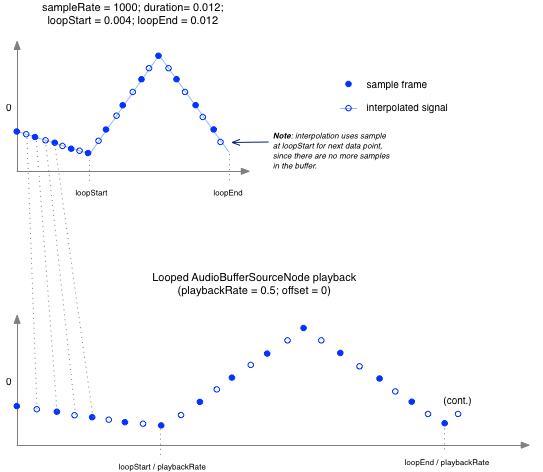

1.4. AudioBuffer

インターフェース

このインターフェースはメモリ上のオーディオアセットを表します。1つ以上のチャンネルを持つことができ、各チャンネルは32ビット浮動小数点のリニアPCM値で、名目上の範囲は\([-1,1]\)ですが、値がこの範囲に制限されているわけではありません。通常、PCMデータの長さはかなり短い(たいてい1分未満)ことが期待されます。

より長い音声(音楽のサウンドトラックなど)には、audio要素やMediaElementAudioSourceNodeを用いたストリーミングを使用してください。

AudioBufferは

1つ以上のAudioContextで利用でき、

OfflineAudioContextとAudioContext間で共有できます。

AudioBufferには4つの内部スロットがあります:

[[number of channels]]-

この

AudioBufferのオーディオチャンネル数(unsigned long)。 [[length]]-

この

AudioBufferの各チャンネルの長さ(unsigned long)。 [[sample rate]]-

この

AudioBufferのサンプルレート(Hz、float)。 [[internal data]]-

オーディオサンプルデータを保持するデータブロック。

[Exposed =Window ]interface AudioBuffer {constructor (AudioBufferOptions );options readonly attribute float sampleRate ;readonly attribute unsigned long length ;readonly attribute double duration ;readonly attribute unsigned long numberOfChannels ;Float32Array getChannelData (unsigned long );channel undefined copyFromChannel (Float32Array ,destination unsigned long ,channelNumber optional unsigned long = 0);bufferOffset undefined copyToChannel (Float32Array ,source unsigned long ,channelNumber optional unsigned long = 0); };bufferOffset

1.4.1. コンストラクタ

AudioBuffer(options)-

-

optionsの値が名目上の範囲外の場合は、NotSupportedError例外を投げて以降の手順を中断します。 -

b を新しい

AudioBufferオブジェクトとして作成します。 -

コンストラクタに渡された

AudioBufferOptionsのnumberOfChannels,length,sampleRateの値を、それぞれ内部スロット[[number of channels]],[[length]],[[sample rate]]に割り当てます。 -

この

AudioBufferの内部スロット[[internal data]]をCreateByteDataBlock(の呼び出し結果に設定します。[[length]]*[[number of channels]])注:これは基礎となるストレージをゼロで初期化します。

-

b を返します。

AudioBuffer.constructor() メソッドの引数。 パラメータ 型 Nullable Optional 説明 optionsAudioBufferOptions✘ ✘ この AudioBufferのプロパティを決定するAudioBufferOptions。 -

1.4.2. 属性

duration, 型 double, 読み取り専用-

PCMオーディオデータの長さ(秒単位)。

これは

[[sample rate]]と[[length]]の値を使い、AudioBufferについて[[length]]を[[sample rate]]で割って算出します。 length, 型 unsigned long, 読み取り専用-

PCMオーディオデータの長さ(サンプルフレーム数)。これは

[[length]]の値を返す必要があります。 numberOfChannels, 型 unsigned long, 読み取り専用-

離散的なオーディオチャンネル数。この値は

[[number of channels]]の値を返す必要があります。 sampleRate, 型 float, 読み取り専用-

PCMオーディオデータのサンプルレート(1秒あたりのサンプル数)。この値は

[[sample rate]]の値を返す必要があります。

1.4.3. メソッド

copyFromChannel(destination, channelNumber, bufferOffset)-

copyFromChannel()メソッドは、指定されたチャンネルのAudioBufferからdestination配列へサンプルをコピーします。bufferをAudioBuffer(フレーム数\(N_b\))とし、destination配列の要素数を\(N_f\)、bufferOffsetの値を\(k\)とします。 コピーされるフレーム数は \(\max(0, \min(N_b - k, N_f))\)です。これが\(N_f\)未満の場合、残りのdestinationの要素は 変更されません。AudioBuffer.copyFromChannel() メソッドの引数。 パラメータ 型 Nullable Optional 説明 destinationFloat32Array✘ ✘ チャンネルデータがコピーされる配列。 channelNumberunsigned long✘ ✘ コピー元のチャンネルのインデックス。 channelNumberがAudioBufferの チャンネル数以上の場合、IndexSizeErrorを必ず投げる必要があります。bufferOffsetunsigned long✘ ✔ オプションのオフセット。デフォルトは0です。 AudioBufferのこのオフセットからdestinationへデータがコピーされます。返り値型:undefined copyToChannel(source, channelNumber, bufferOffset)-

copyToChannel()メソッドはsource配列から 指定されたチャンネルのAudioBufferへサンプルをコピーします。UnknownErrorは、sourceが バッファにコピーできない場合に投げられることがあります。bufferをAudioBuffer(フレーム数\(N_b\))、source配列の要素数を\(N_f\)、bufferOffsetの値を\(k\)とします。 コピーされるフレーム数は \(\max(0, \min(N_b - k, N_f))\)です。これが\(N_f\)未満の場合、残りのbufferの要素は変更されません。AudioBuffer.copyToChannel() メソッドの引数。 パラメータ 型 Nullable Optional 説明 sourceFloat32Array✘ ✘ チャンネルデータのコピー元となる配列。 channelNumberunsigned long✘ ✘ データをコピーするチャンネルのインデックス。 channelNumberがAudioBufferの チャンネル数以上の場合、IndexSizeErrorを必ず投げる必要があります。bufferOffsetunsigned long✘ ✔ オプションのオフセット。デフォルトは0です。 sourceのデータがAudioBufferのこのオフセットからコピーされます。返り値型:undefined getChannelData(channel)-

acquire the contentで記載されたルールに従い、書き込みを許可するか、 またはコピーを取得して、

[[internal data]]内のバイトを新しいFloat32Arrayで返します。UnknownErrorは、[[internal data]]や新しいFloat32Arrayが 作成できない場合に投げられることがあります。AudioBuffer.getChannelData() メソッドの引数。 パラメータ 型 Nullable Optional 説明 channelunsigned long✘ ✘ データ取得対象となるチャンネルを表すインデックス。0は最初のチャンネル。このインデックス値は [[number of channels]]未満でなければならず、 そうでなければIndexSizeError例外を必ず投げる必要があります。返り値型:Float32Array

注: copyToChannel()およびcopyFromChannel()は、

Float32Arrayで

より大きな配列の一部を埋めるために利用できます。AudioBufferのチャンネルから

データを読み出し、チャンク単位で処理する場合は、copyFromChannel()を

getChannelData()で

取得した配列を直接アクセスするより優先して使うべきです。不要なメモリ割り当てやコピーを回避できる場合があります。

内部操作acquire the

contents of an AudioBufferは、

AudioBufferの

内容がAPI実装で必要な場合に呼び出されます。この操作は呼び出し元に不変なチャンネルデータを返します。

AudioBufferでacquire the content操作が発生した場合、以下の手順を実行します:

-

AudioBufferのArrayBufferが detachedであれば、trueを返して手順を中断し、 呼び出し元に長さ0のチャンネルデータバッファを返す。 -

この

AudioBufferで 以前getChannelData()で返された配列のArrayBufferを Detachする。注:

AudioBufferはcreateBuffer()またはAudioBufferの コンストラクタでのみ作成されるため、これは例外を投げません。 -

それら

[[internal data]]の 基礎となるストレージを保持し、呼び出し元にその参照を返す。 -

データのコピーを含む

ArrayBufferをAudioBufferに アタッチし、次回getChannelData()呼び出し時に返す。

acquire the contents of an AudioBuffer操作は以下の場合に呼び出されます:

-

AudioBufferSourceNode.startが呼ばれたとき、ノードのbufferの 内容を取得します。 操作に失敗した場合、何も再生されません。 -

bufferがAudioBufferSourceNodeで セットされ、AudioBufferSourceNode.startが 以前に呼ばれている場合、セッターはAudioBufferの 内容を取得します。操作に失敗した場合、何も再生されません。 -

ConvolverNodeのbufferがAudioBufferに セットされたとき、AudioBufferの 内容を取得します。 -

AudioProcessingEventの ディスパッチが完了したときは、outputBufferの 内容を取得します。

注: copyToChannel()は

AudioBufferの

内容がAudioNodeに

acquire the

content of an AudioBufferで取得された場合、その内容を変更することはできません。

AudioNodeは

取得時点のデータを引き続き使用します。

1.4.4. AudioBufferOptions

これはAudioBufferの構築時に使用するオプションを指定します。

lengthと

sampleRateメンバーは

必須です。

dictionary AudioBufferOptions {unsigned long numberOfChannels = 1;required unsigned long length ;required float sampleRate ; };

1.4.4.1. 辞書 AudioBufferOptions

のメンバー

この辞書のメンバーに許可される値は制約されています。createBuffer()

を参照してください。

length, 型 unsigned long-

バッファのサンプルフレーム数。制約については

lengthを参照してください。 numberOfChannels, 型 unsigned long, デフォルト値は1-

バッファのチャンネル数。制約については

numberOfChannelsを参照してください。 sampleRate, 型 float-

バッファのサンプルレート(Hz)。制約については

sampleRateを参照してください。

1.5. AudioNode

インターフェース

AudioNodeは

AudioContext

の構成要素です。このインターフェースは

オーディオソース、オーディオ出力先、および中間処理モジュールを表します。これらのモジュールは相互に接続することで処理グラフを形成し、

オーディオハードウェアへのレンダリングを行います。各ノードは入力や出力を持つことができます。ソースノードは入力を持たず出力は1つです。フィルターなどのほとんどの処理ノードは入力1つ、出力1つとなります。各AudioNodeの

音声処理や合成の詳細は異なりますが、一般的にAudioNodeは

入力(ある場合)を処理し、出力(ある場合)用の音声を生成します。

各出力は1つ以上のチャンネルを持ちます。正確なチャンネル数は個々のAudioNodeの詳細によります。

出力は1つ以上のAudioNodeの

入力に接続できるため、ファンアウトがサポートされています。入力は最初は接続がありませんが、1つ以上のAudioNodeの

出力から接続されることができ、ファンインもサポートされています。connect()メソッドで

AudioNodeの

出力を別のAudioNodeの

入力に接続すると、その入力への接続が発生したと呼びます。

各AudioNodeの

入力は、任意の時点で特定のチャンネル数を持ちます。

このチャンネル数は、入力への接続状況に応じて変化します。入力に接続がない場合は、1チャンネル(無音)となります。

各入力について、AudioNodeは

その入力への全ての接続をミキシングします。

規定の要件や詳細については§ 4 チャンネルのアップミックス・ダウンミックスを参照してください。

入力の処理およびAudioNodeの

内部処理は、ノードに接続された出力があるかどうか、またそれらの出力が

AudioContextの

AudioDestinationNodeに

到達するかどうかに関わらず、AudioContextの

時間を基準に継続的に行われます。

[Exposed =Window ]interface AudioNode :EventTarget {AudioNode connect (AudioNode destinationNode ,optional unsigned long output = 0,optional unsigned long input = 0);undefined connect (AudioParam destinationParam ,optional unsigned long output = 0);undefined disconnect ();undefined disconnect (unsigned long output );undefined disconnect (AudioNode destinationNode );undefined disconnect (AudioNode destinationNode ,unsigned long output );undefined disconnect (AudioNode destinationNode ,unsigned long output ,unsigned long input );undefined disconnect (AudioParam destinationParam );undefined disconnect (AudioParam destinationParam ,unsigned long output );readonly attribute BaseAudioContext context ;readonly attribute unsigned long numberOfInputs ;readonly attribute unsigned long numberOfOutputs ;attribute unsigned long channelCount ;attribute ChannelCountMode channelCountMode ;attribute ChannelInterpretation channelInterpretation ; };

1.5.1. AudioNodeの生成

AudioNodeは

2つの方法で生成できます。1つはこのインターフェースのコンストラクタを利用する方法、もう1つはBaseAudioContext

または AudioContext上の

ファクトリメソッドを利用する方法です。

BaseAudioContextを

AudioNodeのコンストラクタの

第1引数として渡す場合、それは生成されるAudioNodeの

関連付けられたBaseAudioContextとなります。

同様に、ファクトリメソッドを利用した場合も、関連付けられた

BaseAudioContextは、そのファクトリメソッドを呼び出したBaseAudioContextです。

AudioNodeを

BaseAudioContext

c上のファクトリメソッドで生成するには、以下の手順を実行します。

-

nodeを型nの新しいオブジェクトとして生成する。

-

optionを、このファクトリメソッドに関連するインターフェースに関連付けられている オプション辞書型として用意する。

-

ファクトリメソッドに渡された各パラメータについて、同じ名前の辞書メンバーに値をセットする。

-

cとoptionを引数に、nのコンストラクタをnode上で呼び出す。

-

nodeを返す。

-

oの

BaseAudioContextをcontextに設定する。 -

このインターフェースの仕様に記載されたデフォルト値に従い、

numberOfInputs、numberOfOutputs、channelCount、channelCountMode、channelInterpretationの値を設定する。 -

dictの各メンバーについて、キーkと値vで以下の手順を実行する。手順実行時に例外が発生した場合は、 イテレーションを中断し、その例外をアルゴリズム(コンストラクタまたはファクトリメソッド)の呼び出し元へ伝播する。

-

kがこのインターフェース上の

AudioParam名である場合、 そのvalue属性にvをセットする。 -

それ以外の場合、kがこのインターフェース上の属性名であれば、関連するオブジェクトの属性値をvにセットする。

-

ファクトリメソッドの関連インターフェースは、 そのメソッドが返すオブジェクトのインターフェースです。インターフェースの関連オプションオブジェクトは、 そのインターフェースのコンストラクタに渡すことができるオプションオブジェクトです。

AudioNodeは

EventTargetであり、

[DOM]に記載されています。

つまりAudioNodeにも、

他のEventTarget同様に

イベントを配送できます。

enum {ChannelCountMode "max" ,"clamped-max" ,"explicit" };

ChannelCountModeは、

ノードのchannelCountや

channelInterpretation値と

組み合わせて

ノードの入力をどのようにミックスするかを制御するcomputedNumberOfChannelsを決定します。computedNumberOfChannelsの決定方法は以下に示します。

ミックス方法の詳細は§ 4 チャンネルのアップミックス・ダウンミックスを参照してください。

| 列挙値 | 説明 |

|---|---|

"max"

| computedNumberOfChannelsは

入力へのすべての接続のチャンネル数の最大値となります。このモードではchannelCountは無視されます。

|

"clamped-max"

| computedNumberOfChannelsは

"max"と同様に決定され、その後指定されたchannelCountの最大値にクランプされます。

|

"explicit"

| computedNumberOfChannelsは

channelCountで指定された値となります。

|

enum {ChannelInterpretation "speakers" ,"discrete" };

| 列挙値 | 説明 |

|---|---|

"speakers"

| アップミックス方程式やダウンミックス方程式を使用します。 チャンネル数が基本的なスピーカーレイアウトと一致しない場合は"discrete"にフォールバックします。 |

"discrete"

| チャンネルが尽きるまで埋めて残りはゼロでアップミックス。ダウンミックスは埋められるだけ埋めて残りは削除します。 |

1.5.2. AudioNodeのテイルタイム

AudioNodeには

テイルタイムが存在する場合があります。

これはAudioNodeに

サイレンスが入力されても、出力がサイレンスにならない場合があることを意味します。

AudioNodeは

入力の過去の値が将来の出力に影響を与えるような内部処理状態を持つ場合、非ゼロのテイルタイムを持ちます。

入力が非サイレンスからサイレンスに遷移した後も、計算されたテイルタイムの間非サイレンスな出力を生成し続ける場合があります。

1.5.3. AudioNodeのライフタイム

AudioNodeは、以下のいずれかの条件を満たす場合、レンダー量子中にアクティブ処理中となります。

-

AudioScheduledSourceNodeは、現在のレンダリング量子の一部でも再生中ならば、アクティブ処理中です。 -

MediaElementAudioSourceNodeは、対応するmediaElementが現在のレンダリング量子の一部でも再生中ならば、アクティブ処理中です。 -

MediaStreamAudioSourceNodeやMediaStreamTrackAudioSourceNodeは、関連付けられたMediaStreamTrackオブジェクトのreadyState属性が"live"、muted属性がfalse、enabled属性がtrueであるとき、アクティブ処理中です。 -

サイクル内の

DelayNodeは、現在のレンダー量子の出力サンプルの絶対値が\( 2^{-126} \)以上のときのみアクティブ処理中です。 -

ScriptProcessorNodeは、入力または出力が接続されているときアクティブ処理中です。 -

AudioWorkletNodeは、AudioWorkletProcessorの[[callable process]]がtrueを返し、かつアクティブソースフラグがtrueか、いずれかの入力に接続されているAudioNodeがアクティブ処理中の場合にアクティブ処理中です。 -

その他の

AudioNodeは、いずれかの入力に接続されたAudioNodeがアクティブ処理中のときアクティブ処理中となり、他のアクティブ処理中のAudioNodeから受け取った入力が出力に影響しなくなった場合にアクティブ処理中を終了します。

注: これはテイルタイムを持つAudioNodeも考慮しています。

アクティブ処理中でないAudioNodeは、サイレンス(無音)の1チャンネルのみを出力します。

1.5.4. 属性

channelCount, 型 unsigned long-

channelCountは、 ノードへの入力をアップミックス・ダウンミックスする際に使用されるチャンネル数です。デフォルト値は2ですが、特定ノードでは値が異なる場合があります。この属性は入力のないノードには効果がありません。この値が0または実装の最大チャンネル数を超えて設定された場合、NotSupportedError例外を必ず投げる必要があります。さらに、特定ノードにはチャンネル数の値に対する追加のchannelCount制約があります:

AudioDestinationNode-

このノードが

AudioContextかOfflineAudioContextの出力先かで挙動が異なります。AudioContext-

チャンネル数は1から

maxChannelCountまででなければなりません。この範囲外に設定しようとするとIndexSizeError例外を必ず投げる必要があります。 OfflineAudioContext-

チャンネル数は変更できません。値を変更しようとした場合は

InvalidStateError例外を必ず投げる必要があります。

AudioWorkletNodeChannelMergerNode-

チャンネル数は変更できません。値を変更しようとした場合は

InvalidStateError例外を必ず投げる必要があります。 ChannelSplitterNode-

チャンネル数は変更できません。値を変更しようとした場合は

InvalidStateError例外を必ず投げる必要があります。 ConvolverNode-

チャンネル数は2より大きくできません。2より大きい値に変更しようとした場合は

NotSupportedError例外を必ず投げる必要があります。 DynamicsCompressorNode-

チャンネル数は2より大きくできません。2より大きい値に変更しようとした場合は

NotSupportedError例外を必ず投げる必要があります。 PannerNode-

チャンネル数は2より大きくできません。2より大きい値に変更しようとした場合は

NotSupportedError例外を必ず投げる必要があります。 ScriptProcessorNode-

チャンネル数は変更できません。値を変更しようとした場合は

NotSupportedError例外を必ず投げる必要があります。 StereoPannerNode-

チャンネル数は2より大きくできません。2より大きい値に変更しようとした場合は

NotSupportedError例外を必ず投げる必要があります。

この属性については§ 4 チャンネルのアップミックス・ダウンミックスも参照してください。

channelCountMode, 型 ChannelCountMode-

channelCountModeは、ノードへの入力をアップミックス・ダウンミックスする際にチャンネル数をどのように決定するかを指定します。デフォルト値は"max"です。この属性は入力のないノードには効果がありません。さらに、特定ノードにはchannelCountMode値に対する追加のchannelCountMode制約があります:

AudioDestinationNode-

このノードが

OfflineAudioContextのdestinationノードである場合、channelCountModeは変更できません。値を変更しようとした場合はInvalidStateError例外を必ず投げる必要があります。 ChannelMergerNode-

channelCountModeは"

explicit"から変更できません。値を変更しようとした場合はInvalidStateError例外を必ず投げる必要があります。 ChannelSplitterNode-

channelCountModeは"

explicit"から変更できません。値を変更しようとした場合はInvalidStateError例外を必ず投げる必要があります。 ConvolverNode-

channelCountModeは"

max"に設定できません。"max"に設定しようとした場合はNotSupportedError例外を必ず投げる必要があります。 DynamicsCompressorNode-

channelCountModeは"

max"に設定できません。"max"に設定しようとした場合はNotSupportedError例外を必ず投げる必要があります。 PannerNode-

channelCountModeは"

max"に設定できません。"max"に設定しようとした場合はNotSupportedError例外を必ず投げる必要があります。 ScriptProcessorNode-

channelCountModeは"

explicit"から変更できません。値を変更しようとした場合はNotSupportedError例外を必ず投げる必要があります。 StereoPannerNode-

channelCountModeは"

max"に設定できません。"max"に設定しようとした場合はNotSupportedError例外を必ず投げる必要があります。

この属性については§ 4 チャンネルのアップミックス・ダウンミックスも参照してください。

channelInterpretation, 型 ChannelInterpretation-

channelInterpretationは、ノードへの入力をアップミックス・ダウンミックスする際に各チャンネルをどのように扱うかを指定します。デフォルト値は"speakers"です。この属性は入力のないノードには効果がありません。さらに、特定ノードにはchannelInterpretation値に対する追加のchannelInterpretation制約があります:

ChannelSplitterNode-

channelInterpretationは"

discrete"から変更できません。値を変更しようとした場合はInvalidStateError例外を必ず投げる必要があります。

この属性については§ 4 チャンネルのアップミックス・ダウンミックスも参照してください。

context, 型 BaseAudioContext, 読み取り専用-

この

AudioNodeを所有するBaseAudioContextです。 numberOfInputs, 型 unsigned long, 読み取り専用-

この

AudioNodeに入力される入力の数です。ソースノードの場合は0となります。多くのAudioNode型ではこの値は固定ですが、ChannelMergerNodeやAudioWorkletNodeのように可変な場合もあります。 numberOfOutputs, 型 unsigned long, 読み取り専用-

この

AudioNodeから出力される出力の数です。この値は一部のAudioNode型では固定ですが、ChannelSplitterNodeやAudioWorkletNodeのように可変な場合もあります。

1.5.5. メソッド

connect(destinationNode, output, input)-

特定ノードのある出力と、別の特定ノードのある入力との間には、1つの接続のみが可能です。同じ終端同士で複数回接続を試みても無視されます。

このメソッドは

destinationAudioNodeオブジェクトを返します。AudioNode.connect(destinationNode, output, input) メソッドの引数。 パラメータ 型 Nullable Optional 説明 destinationNodedestinationパラメータは接続先のAudioNodeです。もしdestinationパラメータが別のAudioContextで作成されたAudioNodeの場合は、InvalidAccessError例外を必ず投げる必要があります。つまり、AudioNodeはAudioContext間で共有できません。複数のAudioNodeを同じAudioNodeに接続することも可能です(チャンネルのアップミックス・ダウンミックス参照)。outputunsigned long✘ ✔ outputパラメータは、どのAudioNode出力から接続するかを示すインデックスです。このパラメータが範囲外の場合、IndexSizeError例外を必ず投げる必要があります。1つのAudioNode出力を複数の入力に接続することも可能(ファンアウト)。inputinputパラメータは接続先AudioNodeのどの入力かを示すインデックスです。このパラメータが範囲外の場合、IndexSizeError例外を必ず投げる必要があります。また、AudioNode同士を接続して、サイクル(一方がもう一方に接続し、さらに元のノードやそのAudioParamへ戻る接続)も作成できます。返り値型:AudioNode connect(destinationParam, output)-

AudioNodeをAudioParamに接続し、a-rate信号でパラメータ値を制御します。1つの

AudioNode出力を複数のAudioParamに接続することも可能(ファンアウト)。複数の

AudioNode出力を1つのAudioParamに接続することも可能(ファンイン)。AudioParamは、接続されたAudioNode出力からレンダリングされたオーディオデータを受け取り、モノラルでない場合はダウンミックスしてモノラル化し、他の出力とミックスし、さらに本来のパラメータ値(オーディオ接続がないときのvalue値とタイムライン変更)とも最終的にミックスします。モノラルへのダウンミックスは、

AudioNodeでchannelCount= 1、channelCountMode= "explicit"、channelInterpretation= "speakers"と同等です。特定ノードのある出力と、特定の

AudioParamとの間には1つの接続のみが可能です。同じ終端同士で複数回接続を試みても無視されます。AudioNode.connect(destinationParam, output) メソッドの引数。 パラメータ 型 Nullable Optional 説明 destinationParamAudioParam✘ ✘ destinationパラメータは接続先のAudioParamです。このメソッドはdestinationAudioParamオブジェクトを返しません。destinationParamが、 そのAudioNodeの作成元とは異なるBaseAudioContextに所属している場合は、InvalidAccessError例外を必ず投げる必要があります。outputunsigned long✘ ✔ outputパラメータはどのAudioNode出力から接続するかを示すインデックスです。このパラメータが範囲外の場合、IndexSizeError例外を必ず投げる必要があります。返り値型:undefined disconnect()-

AudioNodeからのすべての出力接続を切断します。パラメータなし。返り値型:undefined disconnect(output)-

指定した

AudioNodeの出力ひとつから、接続されているAudioNodeまたはAudioParamすべてを切断します。AudioNode.disconnect(output) メソッドの引数。 パラメータ 型 Nullable Optional 説明 outputunsigned long✘ ✘ 切断する AudioNodeの出力のインデックス。指定した出力からのすべての出力接続を切断します。このパラメータが範囲外の場合、IndexSizeError例外を必ず投げる必要があります。返り値型:undefined disconnect(destinationNode)-

指定した

AudioNodeへのすべての出力接続を切断します。AudioNode.disconnect(destinationNode) メソッドの引数。 パラメータ 型 Nullable Optional 説明 destinationNode切断対象の AudioNodeです。指定したdestinationNodeへのすべての出力接続を切断します。指定したdestinationNodeへの接続がない場合、InvalidAccessError例外を必ず投げる必要があります。返り値型:undefined disconnect(destinationNode, output)-

指定した

AudioNodeの特定の出力を、任意の入力からすべて切断します。AudioNode.disconnect(destinationNode, output) メソッドの引数。 パラメータ 型 Nullable Optional 説明 destinationNode切断対象の AudioNodeです。指定した出力からdestinationNodeへの接続がない場合、InvalidAccessError例外を必ず投げる必要があります。outputunsigned long✘ ✘ 切断する AudioNodeの出力のインデックス。このパラメータが範囲外の場合、IndexSizeError例外を必ず投げる必要があります。返り値型:undefined disconnect(destinationNode, output, input)-

指定した

AudioNodeの特定の出力から、指定した入力への接続のみを切断します。AudioNode.disconnect(destinationNode, output, input) メソッドの引数。 パラメータ 型 Nullable Optional 説明 destinationNode切断対象の AudioNodeです。指定した出力から指定した入力へのdestinationNodeへの接続がない場合、InvalidAccessError例外を必ず投げる必要があります。outputunsigned long✘ ✘ 切断する AudioNodeの出力のインデックス。このパラメータが範囲外の場合、IndexSizeError例外を必ず投げる必要があります。input切断する AudioNodeの入力のインデックス。このパラメータが範囲外の場合、IndexSizeError例外を必ず投げる必要があります。返り値型:undefined disconnect(destinationParam)-

指定した

AudioParamへのすべての出力接続を切断します。このAudioNodeのパラメータ値への寄与は、この操作が有効になった時点で0になります。パラメータの本来の値はこの操作で影響を受けません。AudioNode.disconnect(destinationParam) メソッドの引数。 パラメータ 型 Nullable Optional 説明 destinationParamAudioParam✘ ✘ 切断対象の AudioParamです。指定したdestinationParamへの接続がない場合、InvalidAccessError例外を必ず投げる必要があります。返り値型:undefined disconnect(destinationParam, output)-

指定した

AudioNodeの特定の出力から、指定したAudioParamへの接続のみを切断します。このAudioNodeのパラメータ値への寄与は、この操作が有効になった時点で0になります。パラメータの本来の値はこの操作で影響を受けません。AudioNode.disconnect(destinationParam, output) メソッドの引数。 パラメータ 型 Nullable Optional 説明 destinationParamAudioParam✘ ✘ 切断対象の AudioParamです。指定したdestinationParamへの接続がない場合、InvalidAccessError例外を必ず投げる必要があります。outputunsigned long✘ ✘ 切断する AudioNodeの出力のインデックス。このパラメータが範囲外の場合、IndexSizeError例外を必ず投げる必要があります。返り値型:undefined

1.5.6.

AudioNodeOptions

これはすべてのAudioNodeの構築時に使用できるオプションを指定します。

すべてのメンバーは省略可能ですが、各ノードで使用される具体的な値はノードごとに異なります。

dictionary AudioNodeOptions {unsigned long channelCount ;ChannelCountMode channelCountMode ;ChannelInterpretation channelInterpretation ; };

1.5.6.1. 辞書 AudioNodeOptions

のメンバー

channelCount, 型 unsigned long-

channelCount属性に指定する希望するチャンネル数。 channelCountMode, 型 ChannelCountMode-

channelCountMode属性に指定する希望するモード。 channelInterpretation, 型 ChannelInterpretation-

channelInterpretation属性に指定する希望するモード。

1.6. AudioParam

インターフェース

AudioParam

はAudioNodeの機能(たとえば音量)など個別の要素を制御します。

パラメータはvalue属性で即座に値を設定したり、値の変化を非常に正確なタイミング(AudioContextのcurrentTime属性の座標系)でスケジュールできます。これにより、エンベロープ・ボリュームフェード・LFO・フィルタスウィープ・グレインウィンドウ等、任意のタイムラインベースのオートメーションカーブが設定可能です。

また、AudioNodeの出力からのオーディオ信号をAudioParamに接続し、本来のパラメータ値と合算することもできます。

一部の合成・処理AudioNodeは、AudioParam属性を持ち、その値はオーディオサンプル毎に考慮される必要があります。他のAudioParamではサンプル精度が重要ではなく、値の変化はより粗くサンプリングされてもかまいません。各AudioParamは、a-rateパラメータ(サンプルごとに値を考慮する必要あり)か、k-rateパラメータかを指定します。

実装はブロック処理を使用し、各AudioNodeは1つのレンダー量子を処理します。

各レンダー量子ごとに、k-rateパラメータの値は最初のサンプルフレーム時点でサンプリングされ、その値がそのブロック全体で使用されます。a-rateパラメータはブロックの各サンプルフレームごとにサンプリングされます。

AudioParamによっては、automationRate属性で"a-rate"または"k-rate"に設定して制御できます。

個々のAudioParamの説明も参照してください。

各AudioParamはminValueとmaxValue属性を持ち、

これらがパラメータの単純名目範囲となります。実際には、パラメータ値は\([\mathrm{minValue},

\mathrm{maxValue}]\)にクランプされます。詳細は§ 1.6.3 値の算出参照。

多くのAudioParamでは、minValueとmaxValueは最大可能範囲に設定されることが想定されています。この場合、maxValueは最大正単精度浮動小数点値(3.4028235e38)に設定します。(ただしJavaScriptではIEEE-754倍精度のみ対応のため、3.4028234663852886e38と記述する必要があります。)同様にminValueは最小負単精度浮動小数点値(-3.4028235e38、JavaScriptでは-3.4028234663852886e38)に設定します。

AudioParamはゼロ個以上のオートメーションイベントのリストを保持します。各イベントは、そのイベントのオートメーションイベント時刻(AudioContextのcurrentTime座標系で)に関連して、

指定された時間範囲でパラメータ値の変化を指定します。イベントリストはオートメーションイベント時刻の昇順で管理されます。

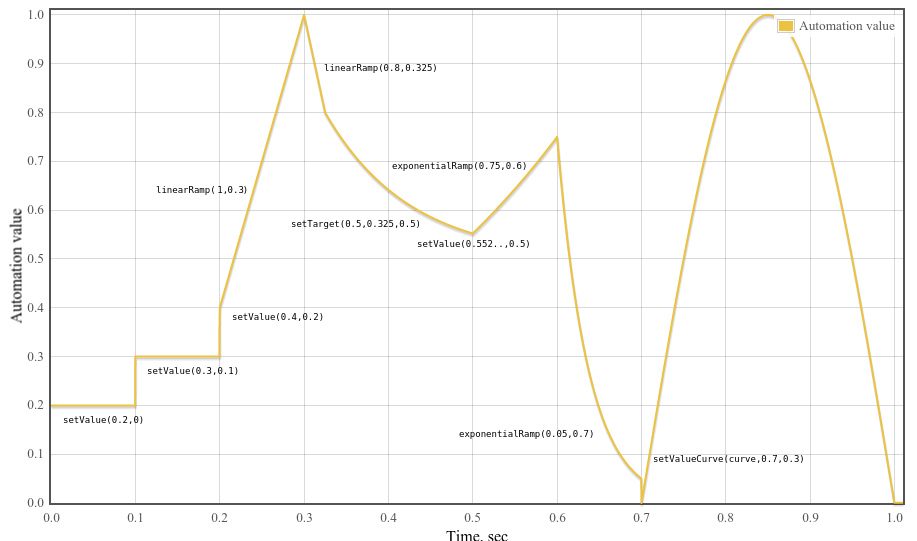

特定のオートメーションイベントの挙動は、AudioContextの現在時刻や、イベントリスト内のこのイベントと隣接するイベントの時刻によって決まります。以下のオートメーションメソッドは、

メソッド固有の型のイベントをイベントリストに追加します:

-

setValueAtTime()-SetValue -

linearRampToValueAtTime()-LinearRampToValue -

exponentialRampToValueAtTime()-ExponentialRampToValue -

setTargetAtTime()-SetTarget -

setValueCurveAtTime()-SetValueCurve

これらのメソッドを呼び出す際の規則:

-

オートメーションイベント時刻は、現在のサンプルレートに量子化されません。カーブやランプの算出式はイベントスケジューリング時に与えられた厳密な数値時刻に適用されます。

-

既に同じ時刻に他のイベントがある場合、新しいイベントはそれらの直後、かつより後の時刻のイベントの前にリストされます。

-

setValueCurveAtTime()が時刻\(T\)、持続時間\(D\)で呼ばれた際、 \(T\)より大きく\(T+D\)より小さい時刻のイベントがある場合はNotSupportedError例外を必ず投げる必要があります。 つまり、他のイベントを含む時間区間に値カーブをスケジューリングすることはできませんが、他のイベントと同じ時刻には可能です。 -

同様に、区間\([T, T+D)\)(\(T\)はカーブの時刻、\(D\)は持続時間)に含まれる時刻で他の

オートメーションメソッドが呼ばれた場合、NotSupportedError例外を必ず投げる必要があります。

注: AudioParam属性は読み取り専用ですが、value属性のみ書き込み可能です。

AudioParamのオートメーションレートは、automationRate属性で以下の値のいずれかに設定できます。ただし、AudioParamによってはオートメーションレートの変更に制約があります。

enum {AutomationRate "a-rate" ,"k-rate" };

| 列挙値 | 説明 |

|---|---|

"a-rate"

| このAudioParamはa-rate処理用に設定されます。

|

"k-rate"

| このAudioParamはk-rate処理用に設定されます。

|

各AudioParamは内部スロット[[current value]]を持ち、

初期値はAudioParamのdefaultValueです。

[Exposed =Window ]interface AudioParam {attribute float value ;attribute AutomationRate automationRate ;readonly attribute float defaultValue ;readonly attribute float minValue ;readonly attribute float maxValue ;AudioParam setValueAtTime (float ,value double );startTime AudioParam linearRampToValueAtTime (float ,value double );endTime AudioParam exponentialRampToValueAtTime (float ,value double );endTime AudioParam setTargetAtTime (float ,target double ,startTime float );timeConstant AudioParam setValueCurveAtTime (sequence <float >,values double ,startTime double );duration AudioParam cancelScheduledValues (double );cancelTime AudioParam cancelAndHoldAtTime (double ); };cancelTime

1.6.1. 属性

automationRate, 型 AutomationRate-

AudioParamのオートメーションレート。 デフォルト値は各AudioParamごとに異なります。個別のAudioParamの説明を参照してください。一部のノードには追加のオートメーションレート制約があります:

AudioBufferSourceNode-

AudioParamのplaybackRateとdetuneは "k-rate"でなければなりません。 レートを"a-rate"に変更しようとした場合はInvalidStateErrorを必ず投げる必要があります。 DynamicsCompressorNode-

AudioParamのthreshold、knee、ratio、attack、releaseは"k-rate"でなければなりません。 レートを"a-rate"に変更しようとした場合はInvalidStateErrorを必ず投げる必要があります。 PannerNode-

panningModelが "HRTF"の場合、PannerNodeのいかなるAudioParamのautomationRateの設定は無視されます。 同様にAudioListenerのAudioParamのautomationRateの設定も無視されます。 この場合、AudioParamはautomationRateが "k-rate"に設定されたかのように振る舞います。

defaultValue, 型 float, 読み取り専用-

value属性の初期値。 maxValue, 型 float, 読み取り専用-

パラメータが取り得る名目上の最大値。

minValueとあわせて、このパラメータの名目範囲を形成します。 minValue, 型 float, 読み取り専用-

パラメータが取り得る名目上の最小値。

maxValueとあわせて、このパラメータの名目範囲を形成します。 value, 型 float-

パラメータの浮動小数点値。この属性は

defaultValueで初期化されます。この属性を取得すると、

[[current value]]スロットの内容を返します。値の算出アルゴリズムは§ 1.6.3 値の算出参照。この属性に値を設定すると、要求された値が

[[current value]]スロットに割り当てられ、setValueAtTime()メソッドが現在のAudioContextのcurrentTimeと[[current value]]で呼び出されます。setValueAtTime()で例外が投げられる場合、この属性の設定でも同じ例外が投げられます。

1.6.2. メソッド

cancelAndHoldAtTime(cancelTime)-

これは

cancelScheduledValues()と似ており、cancelTime以降の すべてのスケジュール済みパラメータ変更をキャンセルします。 ただし、加えて、cancelTime時点で 本来発生するはずだったオートメーション値が、その後他のオートメーションイベントが追加されるまで保持されます。オートメーションが動作中に、

cancelAndHoldAtTime()呼び出し後、cancelTime到達前に オートメーションが追加され得る場合のタイムラインの挙動は複雑です。cancelAndHoldAtTime()の 挙動は以下のアルゴリズムで規定されます。\(t_c\) をcancelTimeの値とする。 次の手順を実行します:-

\(E_1\) を、時刻 \(t_1\)(\(t_1 \le t_c\) を満たす最大の数)のイベント(存在する場合)とする。

-

\(E_2\) を、時刻 \(t_2\)(\(t_c \lt t_2\) を満たす最小の数)のイベント(存在する場合)とする。

-

\(E_2\) が存在する場合:

-

\(E_2\) がリニアまたは指数ランプの場合、

-

\(E_2\) を、同じ種類のランプとして、終了時刻を \(t_c\)、終了値を元のランプの時刻 \(t_c\) における値として書き換える。

-

ステップ5へ。

-

-

それ以外の場合はステップ4へ。

-

-

\(E_1\) が存在する場合:

-

\(E_1\) が

setTargetイベントの場合、-

暗黙的に、時刻 \(t_c\) に

setValueAtTimeイベント(値はsetTargetの \(t_c\) における値)を挿入する。 -

ステップ5へ。

-

-

\(E_1\) が開始時刻 \(t_3\)、期間 \(d\) の

setValueCurveの場合、-

\(t_c \gt t_3 + d\) ならステップ5へ。

-

それ以外の場合、

-

このイベントを、開始時刻 \(t_3\)、新しい期間 \(t_c-t_3\) の

setValueCurveイベントで置き換える。ただし、これは厳密な置換ではなく、元のカーブと同じ出力を生成するように自動化しなければならない。異なる期間で計算すると値曲線のサンプリング方法が変わり、異なる結果となるため。 -

ステップ5へ。

-

-

-

-

時刻 \(t_c\) より後のすべてのイベントを削除する。

イベントが追加されなければ、

cancelAndHoldAtTime()後のオートメーション値は、元のタイムラインが\(t_c\)時点で持つ値を以降保持します。AudioParam.cancelAndHoldAtTime() メソッドの引数。 パラメータ 型 Nullable Optional 説明 cancelTimedouble✘ ✘ この時刻以降のスケジュール済みパラメータ変更をキャンセルする時刻。 AudioContextのcurrentTime座標系の時刻。RangeErrorはcancelTimeが負の場合に必ず投げる必要があります。cancelTimeがcurrentTime未満の場合はcurrentTimeにクランプされます。返り値型:AudioParam -

cancelScheduledValues(cancelTime)-

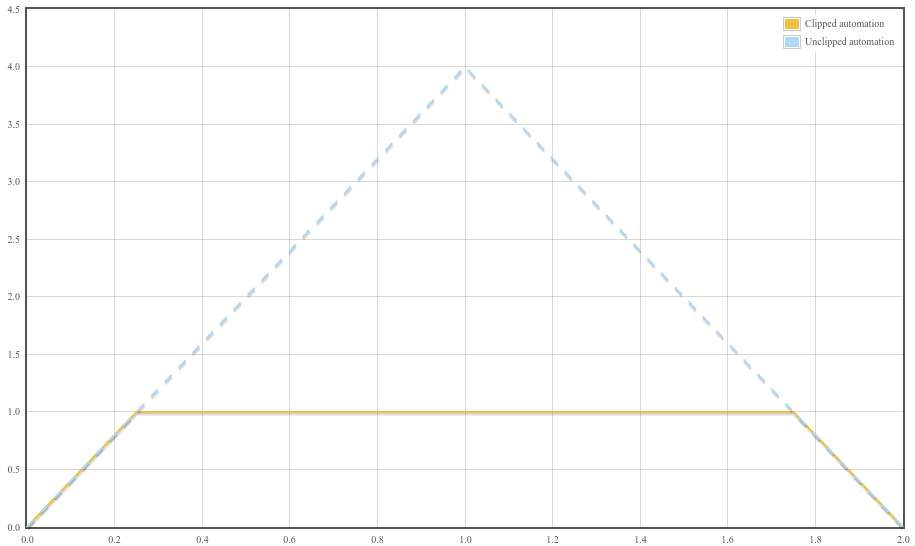

cancelTime以降の すべてのスケジュール済みパラメータ変更をキャンセルします。 キャンセルは、イベントリストから対象イベントを削除することです。automation event timeがcancelTime未満の アクティブなオートメーションもキャンセルされ、元の値(オートメーション前の値)に即座に戻ります。cancelAndHoldAtTime()で 保持された値も、保持時刻がcancelTime以降の場合は削除されます。setValueCurveAtTime()の場合、 \(T_0\)と\(T_D\)をイベントのstartTime、durationとする。cancelTimeが \([T_0, T_0 + T_D]\)区間内にあれば、そのイベントはタイムラインから削除されます。AudioParam.cancelScheduledValues() メソッドの引数。 パラメータ 型 Nullable Optional 説明 cancelTimedouble✘ ✘ この時刻以降のスケジュール済みパラメータ変更をキャンセルする時刻。 AudioContextのcurrentTime座標系の時刻。RangeErrorはcancelTimeが負の場合に必ず投げる必要があります。cancelTimeがcurrentTime未満の場合はcurrentTimeにクランプされます。返り値型:AudioParam exponentialRampToValueAtTime(value, endTime)-

パラメータ値を、前回スケジュールされたパラメータ値から指定された値まで指数関数的に連続して変化させるようにスケジュールします。フィルターの周波数や再生速度を表すパラメータは、人間の音の知覚方法のため、指数関数的に変化させるのが最適です。

時間区間 \(T_0 \leq t < T_1\)(ここで \(T_0\) は前回イベントの時刻、\(T_1\) はこのメソッドに渡された

endTimeパラメータの値)における値は、以下のように計算されます:$$ v(t) = V_0 \left(\frac{V_1}{V_0}\right)^\frac{t - T_0}{T_1 - T_0} $$ここで \(V_0\) は時刻 \(T_0\) における値、\(V_1\) はこのメソッドに渡された

valueパラメータの値です。もし \(V_0\) と \(V_1\) の符号が異なる場合や、\(V_0\) がゼロの場合は、\(T_0 \le t \lt T_1\) の間は \(v(t) = V_0\) となります。このことは、0 への指数関数的ランプが不可能であることも意味します。適切なタイムコンスタントを選択した

setTargetAtTime()を使うことで良い近似が可能です。この ExponentialRampToValue イベントの後にイベントがなければ、\(t \geq T_1\) の間は \(v(t) = V_1\) となります。

このイベントの前にイベントがない場合、指数ランプは

setValueAtTime(value, currentTime)を呼び出したかのように動作します。ここでvalueは属性の現在値、currentTimeはcurrentTimeのコンテキストでexponentialRampToValueAtTime()が呼ばれた時点の値です。直前のイベントが

SetTargetイベントの場合、\(T_0\) および \(V_0\) はSetTargetオートメーションの現在時刻と値から選ばれます。すなわち、SetTargetイベントがまだ開始されていない場合、\(T_0\) はイベントの開始時刻、\(V_0\) はSetTargetイベント開始直前の値です。この場合、ExponentialRampToValueイベントは事実上SetTargetイベントを置き換えます。SetTargetイベントがすでに開始されている場合、\(T_0\) は現時点のコンテキスト時刻、\(V_0\) は時刻 \(T_0\) でのSetTargetオートメーション値です。どちらの場合も、オートメーションカーブは連続になります。AudioParam.exponentialRampToValueAtTime() メソッドの引数。 パラメータ 型 Nullable Optional 説明 valuefloat✘ ✘ 指定時刻に指数的に到達する値。 RangeErrorはこの値が0の場合必ず投げる必要があります。endTimedouble✘ ✘ AudioContextのcurrentTime座標系で 指定する指数ランプ終了時刻。RangeErrorはendTimeが負または有限でない場合必ず投げる必要があります。 endTimeがcurrentTime未満の場合はcurrentTimeにクランプされます。返り値型:AudioParam linearRampToValueAtTime(value, endTime)-

パラメータ値を前回スケジュール値から指定値へ、線形に連続変化するようスケジュールします。

時間区間 \(T_0 \leq t < T_1\)(ここで \(T_0\) は前回のイベントの時刻、\(T_1\) はこのメソッドに渡された

endTimeパラメータの値)における値は、以下のように計算されます:$$ v(t) = V_0 + (V_1 - V_0) \frac{t - T_0}{T_1 - T_0} $$\(V_0\):時刻\(T_0\)での値、\(V_1\):このメソッドの

value。このイベント以降にイベントがなければ \(t \geq T_1\) で値は\(V_1\)となる。

直前にイベントがなければ、

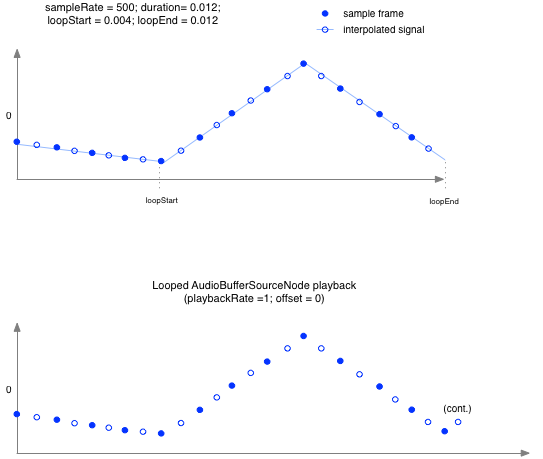

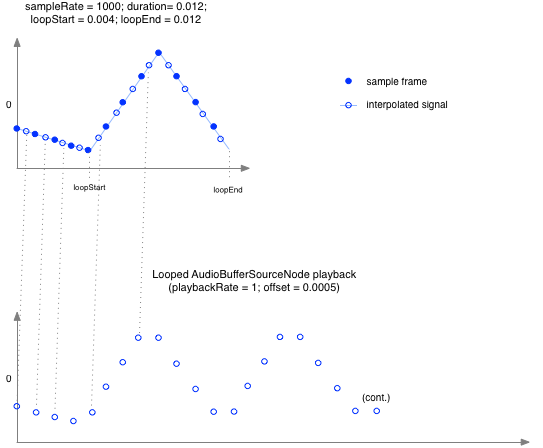

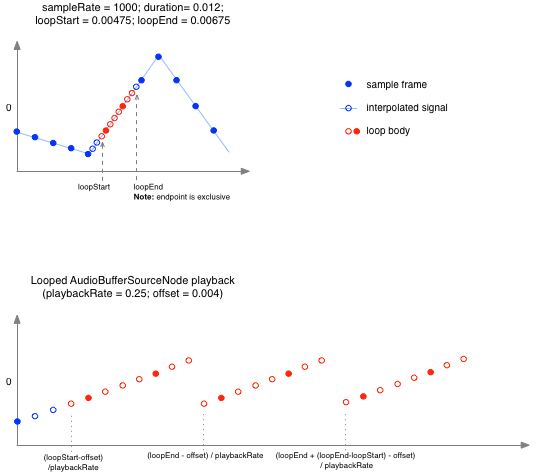

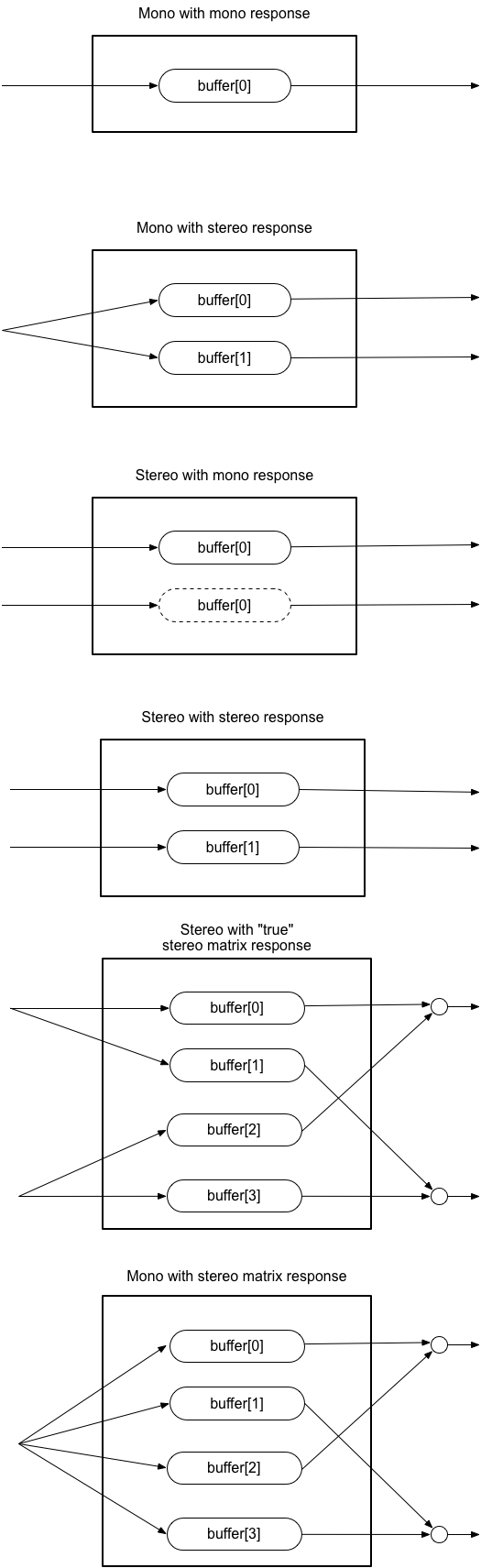

setValueAtTime(value, currentTime)を (value:現在値、currentTime:呼び出し時点のcontext currentTime)呼んだのと同様の挙動。直前が